Zusammenfassung:

Hochschulrankings bilden ein wichtiges Informationsinstrument für Studieninteressierte, Personalverantwortliche und Drittmittelgeber, um in vereinfachter Form die Leistung von Hochschulen durch Rangfolgen miteinander vergleichbar zu machen. Solche Rankings bilden zunehmend ein wichtiges Hilfsmittel, um das Erreichen von Effizienz- und Effektivitätszielen im Vergleich zu anderen Hochschulen zu verfolgen. Für Bibliotheken ist es wichtig, ihre Rolle in solchen Rankings korrekt einschätzen zu können und zu wissen, mit welchen Indikatoren bibliothekarische Leistungen in Hochschulrankings gemessen werden. Mit den so gewonnenen Erkenntnissen können Zielsysteme und Budgetverhandlungen optimiert werden.

Abstract:

University rankings are an important source of information for those interested in academic education, personnel managers and Third-Party donors in order to be able to compare easily the performance of universities. Such rankings increasingly represent an important means of observing the achieving of targets in efficiency and effectiveness, compared with other universities. It is important for libraries to be able to correctly assess their role in such rankings and to know with which indicators the performance of libraries is measured in university rankings. Based on these findings, target systems and budget negotiations can be optimised.

1 „Bibliotheksindikatoren“ in Hochschulrankings

Hochschulen erbringen komplexe Dienstleistungen, bei deren Durchführung viele qualitative Unsicherheiten auftreten, so dass Leistungsmessungen methodisch schwierig sind. Dies begründet die steigende Nachfrage nach Rankings als Informationsinstrument, mit denen versucht wird, durch die Erstellung von Rangfolgen die Komplexität der Leistungsmessung zu reduzieren. Die Art und Weise, wie diese Komplexitätsreduktion vorgenommen wird, also die Methodik der Rankings, bestimmt wiederum die Validität der Ergebnisse.[1]

Zum einen sind Hochschulrankings für die Nachfrageseite von Forschung und Lehre, beispielsweise Studieninteressierte, Personalverantwortliche oder Drittmittelgeber, ein interessantes Instrument, Transparenz herzustellen und Informationsasymmetrien abzubauen. Andererseits sind Rankings aus Sicht der Hochschulleitungen hinsichtlich ihrer Effizienz- und Effektivitätsziele mittlerweile unverzichtbar, denn der Grad der Zielerreichung lässt sich über Output- und Wirkungsmessung gut darstellen.[2]

Die finanzielle Ausstattung von Hochschulbibliotheken hat einen nennenswerten Anteil am Gesamtbudget einer Hochschule und Bibliotheken haben ein Interesse daran, ihren Beitrag zur Gesamtleistung der Hochschule darzustellen. Um sich mit den Unterhaltsträgern über die Mittelausstattung der Bibliothek auseinandersetzen zu können, können Hochschulrankings ein wertvolles Instrument bieten. Voraussetzung ist, dass die Bibliotheken ihren Beitrag zum Erfolg der Hochschule messbar darstellen können und Hochschulrankings bibliothekarische Leistungen überhaupt explizit berücksichtigen.

Die Organisationen, die solche Hochschulrankings durchführen, sind von ihrer Trägerschaft, Struktur und Zielsetzung sehr heterogen – das Spektrum umfasst staatliche Wissenschaftsorganisationen (z. B. Wissenschaftsrat, DFG, Deutscher Hochschulverband, Alexander-von-Humboldt-Stiftung), Hochschulen (z. B. Leiden, Shanghai), gemeinnützige Dienstleister (z. B. Centrum für Hochschulentwicklung und HIS), kommerzielle Beratungs- und Forschungsunternehmen (z. B. Trendence, Quacquarelli Symonds) und Zeitschriftenverlage (z. B. Handelsblatt, Times).

Über den Sinn und den Nutzen von Hochschulrankings wird innerhalb der Hochschulen viel diskutiert. Hochschulen fassen die Ergebnisse zusammen, bewerten ihr Abschneiden und strukturieren die Kritikpunkte.[3] Wertet man diese Ranking Reports aus, so muss man feststellen, dass Indikatoren, die bibliothekarische Dienstleistungen erfassen, in diesen Papieren kaum diskutiert werden. Dennoch haben Bibliotheken ein Interesse, ihren Beitrag zum Erfolg der Hochschule darzustellen, und sie sollten daher auch über Zielrichtung, Struktur und die Indikatoren von Hochschulrankings informiert sein.

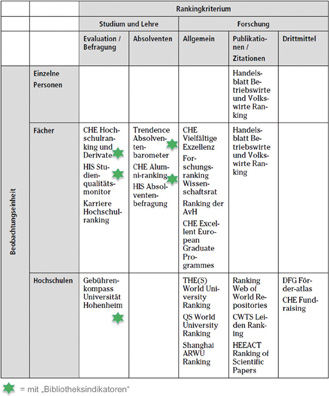

Für eine Analyse der Hochschulrankings und die Einordnung ihrer Relevanz für die wissenschaftlichen Bibliotheken ist eine typologische Einordnung hilfreich. Rankings können in den Bereichen Studium und Lehre, Absolventenrankings, Forschungsrankings, Hochschulrankings mit Schwerpunkt Berufsstart und Karrierechancen und Rankings mit Schwerpunkt Hochschule als Unternehmen sowie internationale Hochschulrankings gefunden werden.[4] Die Struktur, Methoden und Kriterien der Hochschulrankings sind sehr heterogen. Manchmal wird die Hochschule als Ganzes bewertet, manchmal einzelne Fächer. Teils werden Leistungskennzahlen extern erhoben, teils als Selbstauskunft von der Institution geliefert. Manchmal werden Personen befragt, es gibt die unterschiedlichsten Skalen für qualitative Messungen und nicht vergleichbare statistische Modelle. Zielgruppen und Themenfelder überlappen sich zum Teil. Einen Lösungsansatz für eine Typologie von Rankings bietet die Definition von Dilger: „Durch Rankings werden ganz allgemein Beobachtungseinheiten nach einem Kriterium in eine Reihenfolge gebracht.“[5]

Nunmehr können die Hochschulrankings untersucht werden, ob und in welchem Umfang sie bibliotheksfachlich relevante Indikatoren enthalten. Hinsichtlich ihrer typologischen Einordnung handelt es sich dabei um Rankings aus den Bereichen Studium und Lehre, während die Forschungsrankings, was in der Natur der Sache liegt, mehr auf Forschungsoutput und Drittmittel anstatt auf Bibliotheken fokussieren. Die Hochschulrankings, die „Bibliotheksindikatoren“ enthalten, sind in Abb. 1 mit einem Stern gekennzeichnet.

Typologie von Hochschulrankings mit „Bibliotheksindikatoren“.[6]

2 Relevanz und Nutzung von Hochschulrankings

Julius-David Friedrich, Projektmanager beim Centrum für Hochschulentwicklung (CHE) mit Arbeitsschwerpunkt Hochschulranking, untersuchte empirisch die Nutzung von Hochschulrankings. Hierbei treten die Hochschulleitung und die Fachbereiche als wichtige Nutzergruppen von Hochschulrankings in Erscheinung.[7] Diese beiden Nutzergruppen fokussieren dabei besonders auf Stärken- und Schwächenanalysen, das Erkennen von Verbesserungspotenzialen und die Wettbewerbsanalyse. Bei der Hochschulleitung kommt hinzu, dass Hochschulrankings ausgesprochen häufig als Gesprächsgrundlage zwischen Hochschulleitung und den Fachbereichen herangezogen werden.[8] Relevant für das Bibliotheksmanagement ist der Umstand, dass von den Hochschulleitungen häufig Studierenden-Service-Strukturen analysiert werden, wobei es zu einem Abgleich von internen Evaluationen zur Studienqualität mit dem Qualitätsmanagement kommt. Die Ergebnisse von Hochschulrankings wirken sich damit möglicherweise auf die Budgetallokation und damit auf die Mittelzuweisung für den Literaturetat, Sachmittel und Investitionen aus. Wenn Art und Umfang der Literatur- und Informationsversorgung als eine qualitätsbestimmende Größe gemessen werden, erhöht sich die Chance der Bibliothek, eine adäquate Mittelausstattung zu erhalten oder in Zeiten von Budgetkürzungen die aus ihrer Sicht gerechtfertigte Höhe des Etats verteidigen zu können. Überlegungen zur strategischen Personalentwicklung und Ausbauplanung der Hochschule, etwa hinsichtlich der Anzahl der Bibliotheksstandorte oder Magazinflächen, sind weitere Einflussgrößen, bei denen das Abschneiden in Hochschulrankings unmittelbar Auswirkungen auf Planungsgespräche mit den Bibliotheken haben.

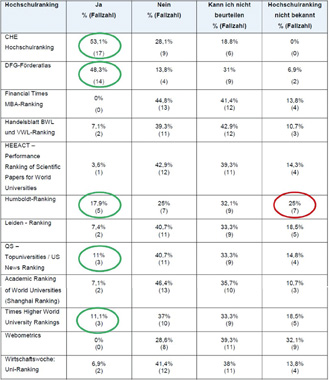

Friedrich hat ferner erhoben, welche weiteren Hochschulrankings außer dem CHE-Ranking von den Hochschulen genutzt werden und wie es um den Bekanntheitsgrad der verschiedenen Rankings bestellt ist (Abb. 2).

Nutzung von Hochschulrankings durch Hochschulen.[9]

Bei der Nutzung schneiden das CHE-Hochschulranking und der DFG-Förderatlas zufriedenstellend ab, die übrigen Rankings kommen auf weit weniger vorteilhafte Werte. Für die fünf grün markierten Hochschulrankings kann für die folgenden Überlegungen eine hinreichende Nutzung seitens der Hochschulen konstatiert werden. Als weiterer Befund fällt in Abb. 2 auf, dass das Ranking der Alexander-von-Humboldt-Stiftung trotz hoher Nutzung bei einigen Hochschulen eine geringe Bekanntheit hat, ohne dass hierfür schlüssige Gründe naheliegen.

Stellt man nun die bibliotheksfachliche Relevanz, gemessen am Vorhandensein sogenannter „Bibliotheksindikatoren“ und die Nutzung durch die Hochschulen, in einem Diagramm graphisch dar, so entsteht Abb. 3.

Einordnung von Hochschulrankings nach fachlicher Relevanz und Verwendung.

Das CHE-Hochschulranking und seine Derivate stehen somit im Fokus der weiteren Betrachtung, da es hinsichtlich seiner Verwendung am häufigsten von den Hochschulen genannt wird und zugleich als einziges der hier untersuchten Rankings auch „Bibliotheksindikatoren“ enthält.

3 Das CHE-Hochschulranking: Ein Ranking mit „Bibliotheksindikatoren“

Das Centrum für Hochschulentwicklung entstand 1994 durch eine gemeinsame Initiative der Hochschulrektorenkonferenz und der Bertelsmann-Stiftung, firmiert als gemeinnützige GmbH und bezeichnet sich selbst als weisungsfrei und unabhängig. Die Präsentation der Ergebnisse des CHE-Hochschulrankings erfolgt über die überregionale deutsche Wochenzeitschrift „Die Zeit“, die in ihrer Online-Ausgabe eine nach Fächern sortierte standardisierte Übersicht bereitstellt. Registrierte Nutzerinnen und Nutzer können nach eigenen Kriterien individuelle Suchen durchführen.

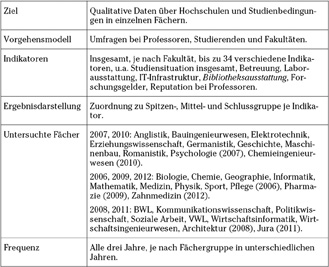

CHE-Hochschulranking. Methodenübersicht.[10]

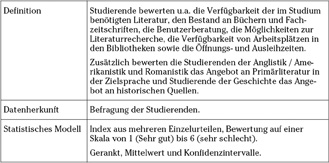

Für das Hochschulranking und das Forschungsranking hat das CHE ein Methoden-Wiki veröffentlicht, das einen umfassenden Überblick über Vorgehensmodell, Datenerhebung, Indikatoren und Ergebnisdarstellung gibt. Im Hochschulranking werden darin bibliothekarische Leistungen im Indikator Bibliotheksausstattung abgefragt.

Indikator Bibliotheksausstattung im CHE-Hochschulranking.[11]

In zwei Auswertungen hat das CHE 2007 die Indikatoren für Ausstattung bewertet: Einmal allgemein die Ausstattung der Hochschulen aus Sicht der Studierenden im Bundesländervergleich, wovon die Bibliotheken einen Teilbereich abdecken[12] , und einmal speziell Universitätsbibliotheken, jedoch eingeschränkt auf die Geisteswissenschaften.[13]

Im Ländervergleich wurde für jedes Bundesland ermittelt, wie hoch der Anteil von Spitzenplatzierungen an der Gesamtzahl der Platzierungen des jeweiligen Bundeslandes ist. Die für die Ausstattung relevanten Indikatoren sind: Studentische Arbeitsplätze, Bibliothek, IT-Infrastruktur, Labore und Räume. Hachmeister/Hennings kommen zu dem Ergebnis, dass „die Studierenden in Sachsen-Anhalt, in Thüringen, in Mecklenburg-Vorpommern und in Sachsen die studentischen Arbeitsplätze, die Bibliotheksausstattung und besonders die Labore sehr häufig positiv“ bewerten.[14] Zur Situation in Hamburg fällt auf, dass „bei den studentischen Arbeitsplätzen sowie bei der Bibliothek kaum Spitzenplatzierungen zu finden sind“.[15]

In der Auswertung der Rolle der Universitätsbibliotheken konzentriert sich Federkeil auf die Geisteswissenschaften, die er als Fächer darstellt, „in denen das Studium in besonderem Maße auf eine gute Literaturversorgung angewiesen ist. Zu diesen sog. ‚Buchwissenschaften’ zählen […] Germanistik, Anglistik/Amerikanistik, Romanistik, Geschichte sowie Erziehungswissenschaften und Psychologie.“[16] Als Einzelaspekte werden betrachtet: Verfügbarkeit der für das Studium benötigten Literatur, Neubeschaffung von Literatur und Aktualität des Bestandes, Zugang zu elektronischen Zeitschriften, Abwicklung von Fernleihbestellungen, Möglichkeiten der Literaturrecherche, Online-Benutzerservice, Benutzerberatung, Verfügbarkeit von Arbeitsplätzen in der Bibliothek, Anzahl der Kopiergeräte und Öffnungszeiten. Die Universitätsbibliotheken Konstanz, Bielefeld, Mannheim, Tübingen und Greifswald werden nach Federkeil in nahezu allen oder sogar allen Einzelaspekten sehr gut bewertet. Bei einigen Bibliotheken werden gute Werte bei der Basiskompetenz Verfügbarkeit und Aktualität des Bestandes wahrgenommen, jedoch Unzufriedenheit mit Servicequalität, Öffnungs- oder Ausleihzeiten.[17]

Das CHE-Hochschulranking wird verschiedentlich von Hochschulen kommentiert und bewertet. Beispielhaft sei die TU München erwähnt, die für eine Reihe von Rankings die Methode und Indikatoren sowie das eigene Abschneiden beschreibt sowie das jeweilige Ranking einer Bewertung unterzieht.[18]

Unterschiedliche fachspezifische Stichprobengrößen werfen die Frage nach der Repräsentativität auf. Auch werden Zweifel an der Angemessenheit und Operationalisierung mancher Indikatoren geäußert: „Ob etwa die Existenz eines umfassenden E-Learning-Angebots einen validen Indikator für die Qualität der Ausstattung darstellt, ist fraglich.“ Bei den Indikatoren für Ausstattung vermengen sich nach Auffassung von Neumeier/Trapp beispielsweise subjektive Bewertung zur Qualität der Arbeitsplätze mit objektiven Ausstattungsparametern. Zudem deckten die bibliometrischen Analysen primär den quantitativen Publikationsoutput in Fachzeitschriften ab, vernachlässigten aber die Qualität der Buchveröffentlichungen. Die Liste der Vorbehalte ist erheblich länger als die hier aufgezählten Punkte.[19] Die Deutsche Gesellschaft für Soziologie äußert erhebliche fachliche Bedenken gegen das CHE-Hochschulranking[20] und kommt zu dem Ergebnis, „dass diese Evaluation grundlegenden Qualitätsanforderungen der empirischen Sozialforschung nicht entspricht.“[21] Die Summe der durchaus bemerkenswerten kritischen Vorbehalte hat jedoch die führende Position des CHE-Rankings hinsichtlich Nutzung und Relevanz bislang offenbar nicht gefährdet.

Ergänzt wird das CHE-Hochschulranking um das CHE-Masterranking und den CHE-Bachelor/Master-Praxischeck. Das CHE-Masterranking ist als Erweiterung des CHE-Hochschulrankings um Urteile von Masterstudierenden zu sehen und wird vom CHE als eigenständige Studie verstanden.[22] Das CHE-Masterranking gibt einen Überblick, wie die zweistufige Studienstruktur sowohl bei den Studierenden als auch bei den Hochschullehrenden angenommen wird und mit welchen Intentionen ein Masterstudium aufgenommen wird. Hinsichtlich des Indikators Bibliothek wurden sechs Indikatoren abgefragt: Verfügbarkeit benötigter Literatur, Aktualität des Bestandes, Zugang zu elektronischen Zeitschriften, Beratung in der Benutzung, Verfügbarkeit von Arbeitsplätzen, Öffnungs- und Ausleihzeiten. Die Bibliotheken werden insgesamt positiv beurteilt, lediglich die Verfügbarkeit von Lernarbeitsplätzen wird – vor allem in den Universitätsbibliotheken – zuweilen kritisch gesehen.[23]

Der CHE-Bachelor/Master-Praxischeck entstand vor dem Hintergrund des Umdenkens im Zuge des Bologna-Prozesses, in dessen Folge der Fokus verstärkt auf die Beschäftigungsbefähigung von Absolventen gelegt wurde und folglich neue Kompetenzen ihren Eingang in Studiengänge und Curricula fanden. Der Praxischeck bewertet als Teilaspekte von Beschäftigungsbefähigung die Vermittlung methodischer Kompetenzen, die Vermittlung sozialer Kompetenzen und die Praxisorientierung der Studiengänge; aus diesen drei Dimensionen wird gleichgewichtig ein Gesamtrating errechnet.[24] Im Feld der methodischen Kompetenzen werden Pflichtmodule für die Themenbereiche IT-Kompetenz, Informationsgewinnung und -recherche, Projekt- und Zeitmanagement und Planspiele gewertet. Je Themenbereich kann ein Punkt erreicht werden, ein weiterer für jeweils mehr als sechs (Master: mehr als vier) Credit Points, insgesamt also bis zu acht Punkte.[25] Hier tritt also das bibliothekarische Feld der Informationsdienstleistungen, speziell die Vermittlung von Informationskompetenz, in Erscheinung und die Hochschule gewinnt einen Vorteil im Ranking, wenn sie Lehrveranstaltungen der Bibliothek zu Informationsgewinnung und -recherche in Form von Pflichtmodulen in ihrem Curriculum verankert.

4 Weitere wichtige Hochschulrankings

Im unteren rechten Quadranten von Abb. 3 sind vier weitere Hochschulrankings zu sehen, die keine bibliotheksfachlich relevanten Indikatoren aufweisen und sämtlich der Kategorie der Forschungsrankings zuzuordnen sind. Dennoch wurden sie in der Befragung von Friedrich von den Hochschulen als Rankings benannt, die von ihnen genutzt werden. Die beiden deutschen Hochschulrankings sollen im Folgenden kurz portraitiert werden.

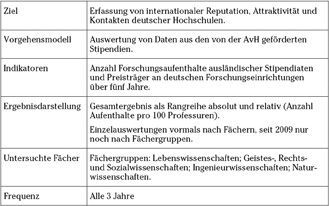

Die Alexander-von-Humboldt-Stiftung (AvH) mit Sitz in Bonn ist eine gemeinnützige Stiftung des Bundes, die die internationale Zusammenarbeit in der Forschung fördert. Ausländische Wissenschaftler werden während eines Aufenthalts in Deutschland gefördert und die sich daraus ergebenden wissenschaftlichen und kulturellen Verbindungen gepflegt. Die AvH argumentiert, dass das Ranking eine Aussage darüber liefert, in welchen Fächergruppen die Hochschulen im internationalen Wettbewerb über besonders gute Kontakte verfügen und eine hohe Reputation besitzen, da die Wissenschaftler sich die jeweilige Forschungseinrichtung selbst auswählen. Hinsichtlich der tatsächlichen Forschungsleistung können aus dem AvH-Ranking keine Rückschlüsse gezogen werden. Dennoch wird das AvH-Ranking als guter ergänzender Faktor gesehen.[26]

Das AvH-Ranking. Methodenübersicht.[27]

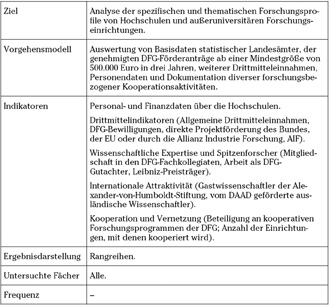

Die Deutsche Forschungsgemeinschaft (DFG) wird gemeinsam von Bund und Ländern getragen und fördert Forschungsprojekte sowie die Zusammenarbeit zwischen Forschenden. Sie berät Parlamente und Behörden und pflegt die Verbindung zwischen Forschung und Wirtschaft sowie zur ausländischen Wissenschaft. Der DFG-Förderatlas von 2012 folgte auf das seit 1997 in fünf Ausgaben erschienene DFG-Förderranking. Der Förderatlas wurde gegenüber seinem Vorgänger inhaltlich und um zahlreiche Tabellen, Grafiken und Karten erweitert. Ziel ist es, umfassend und detailliert Auskunft über die öffentliche Forschungsfinanzierung zu geben sowie Profile und Schwerpunkte von Forschungsförderung zu visualisieren. Bibliothekarische Dienstleistungen werden als Indikator nicht benannt. Sehr wohl ist es am Rande erwähnenswert, dass Bibliotheken als Institutionen im Förderatlas benannt werden, denn sie treten neben den Hochschulen selbst als Empfänger von Forschungsförderung in Erscheinung; wissenschaftliche Bibliotheken und Museen wurden mit etwas über eine Milliarde Euro gefördert.

DFG-Förderatlas. Methodenübersicht.[28]

5 Perspektiven für Bibliotheksrankings

Im Wissenschaftssystem ist es üblich geworden, dass Hochschulen ihre Leistungen in Forschung und Lehre kontinuierlich evaluieren, um mit den Ergebnissen die Grundlage für die Mittelverteilung zu schaffen. Neben dieser steuernden Wirkung wird mit den Evaluationen den Hochschulen gleichzeitig die Chance geboten, Prozesse in Forschung und Lehre im Sinne einer kritischen Reflexion des Zielsystems und eines professionellen Qualitätsmanagementsystems kontinuierlich zu verbessern. Die Fakultäten und zentralen Einrichtungen der Hochschule, darunter auch die Hochschulbibliotheken, sind in das Zielsystem der Hochschule eingebunden und tragen zur Zielerreichung der Hochschule bei. Leistungsmessung spielt also sowohl auf der Ebene der Hochschule als auch auf der Ebene der Hochschulbibliotheken eine wichtige Rolle.

Im Vordergrund des bibliothekarischen Interesses an Leistungsmessung und Leistungsvergleich steht bislang die aus einer Innensicht geprägte Monitoring-Funktion einer gewissen Performance auf der Basis rein technischer Indikatoren, wie die Diskussion um den Bibliotheksindex (BIX) eindrücklich zeigt. Neuere Entwicklungen vor allem aus dem angelsächsischen Raum zeigen, dass Leistungsmessung vermehrt um den Aspekt der Wirkungsmessung erweitert wird, indem nach sogenannten „Wirkungsindikatoren“ gesucht wird.

Im Bibliothekswesen rückt zudem der Dienstleistungsgedanke in Form einer serviceorientierten Fokussierung auf den Bedarf von Nutzerinnen und Nutzern seit Langem in den Vordergrund. Entsprechend konsequent erfolgt die regelmäßige Untersuchung der Nutzerbedürfnisse und Evaluierung der Nutzerakzeptanz von bibliothekarischen Dienstleistungen. Gleichzeitig fließen die Ziele und Strategien der Unterhaltsträger als Anforderungskatalog in das Zielsystem der Bibliotheken ein. Die Leistung und der Erfolg manifestieren sich schlussendlich darin, wie wirkungsvoll Bibliotheken ihre Hochschulen bei der Literatur- und Informationsversorgung für Lehre, Studium und Forschung unterstützen.

Die Bewertungsmaßstäbe für Hochschulbibliotheken wandeln sich rasch: Die Schnelligkeit bei der Verfügbarmachung von Wissen und Information steigt durch digitale Technologie, und bibliothekarische Dienstleistungen sind durch das Internet schon lange nicht mehr nur ortsgebunden. Dieser dynamische Wandel der bibliothekarischen Tätigkeitsfelder geht mit einem hohen Innovations- und somit Investitionsdruck einher. Gleichzeitig werden die Geldmittel, die Unterhaltsträger ihren Bibliotheken zur Verfügung stellen können, kontinuierlich knapper. Bibliotheken werden infolgedessen bereits immer häufiger auch mit betriebswirtschaftlichen Methoden geführt. Für die Hochschulbibliotheken wird es weitgehend unumgänglich, mittels einer fundierten und methodischen Leistungsmessung den Nachweis ihrer Leistungsfähigkeit und ihrer Effektivität zu erbringen und dabei auch den von ihnen erzeugten Mehrwert im Verhältnis zu den in sie investierten Mitteln darzustellen.

Bei der Messung von Leistung kann sowohl die Qualität der Gesamtleistung der Bibliothek im Vordergrund stehen als auch die Messung von Qualität einer bestimmten bibliothekarischen Dienstleistung. In beiden Fällen ergibt sich vorab das Erfordernis, zunächst den Begriff Qualität zu definieren, um dann die Leistung in Beziehung zu den Zielen der Bibliothek zu setzen. Die Auswahl von Indikatoren, mit denen Leistung gemessen werden soll, orientiert sich somit idealerweise eng am Zielsystem der Bibliothek. Die Qualität einer bibliothekarischen Dienstleistung wird nach der einschlägigen ISO-Norm als Eignung definiert, den ihr zugeeigneten Zweck zu erfüllen, wobei der Zweck durch die Bedürfnisse der Nutzerinnen und Nutzer der Bibliothek definiert wird. Somit bedeutet Qualität nicht einen Standard, der isoliert betrachtet werden kann, sondern Qualität orientiert sich immer an den Bedürfnissen der unterschiedlichen Nutzergruppen der Bibliothek.[29]

Da Qualität sich also eng am Zweck orientiert, die Bedürfnisse der Nutzerinnen und Nutzer möglichst gut zu erfüllen, leitet sich als Voraussetzung für Leistungsmessung ab, dass zunächst der Auftrag der Bibliothek festgelegt wird. Für wissenschaftliche Bibliotheken kann dieser Auftrag allgemein definiert werden als „Auswahl, Sammlung, Erschließung und Bereitstellung von Information für Benutzer, in erster Linie für die primäre Nutzergruppe, nämlich die Angehörigen der betreffenden Institution“.[30] Hierdurch leisten die wissenschaftlichen Bibliotheken einen wichtigen Beitrag, um die Wettbewerbsfähigkeit ihrer Hochschule in einem zunehmend überregionalen bzw. internationalen Bildungsmarkt zu unterstützen. Mit einer auf ihren Auftrag konzentrierten Leistungsmessung können die Bibliotheken belegen, dass die Geldmittel und Ressourcen, die die Unterhaltsträger in bibliothekarische Dienstleistungen investieren, angemessen und sinnvoll angelegt sind.

Aus diesem Selbstverständnis ergibt sich ein auf den grundlegenden Auftrag zentriertes Zielsystem der Bibliothek. Typischerweise werden Ziele für einen bedarfsgerechten Bestandsaufbau, größtmögliche Relevanz und schnelle Bereitstellung, sofortige Medienverfügbarkeit, lange Öffnungszeiten, freier Zugang ohne Gebühren o. Ä. festgeschrieben. Ziele für ein umfangreiches Angebot an Informationsdienstleistungen (z. B. Suchportale, Auskunft, Beratung, Schulungen), Räume zum Lernen und Arbeiten, Bestandspflege und Bestandserhaltung u. v. m. werden ebenfalls häufig formuliert. Qualitative Ziele lassen sich ergänzen um operative Ziele, etwa aus den Bereichen Management, Aufbau- und Ablauforganisation, Aus- und Weiterbildung, effizienter Ressourceneinsatz, Einsatz neuer Technologien, Kooperationen in Gremien und Verbundsystemen.

Mit der Forderung nach der Verknüpfung von Leistungsindikatoren mit den Zielen der Bibliothek tritt wiederum die Frage nach der Nutzerorientierung in den Vordergrund. Bei der Erhebung von Benutzerzufriedenheit wird danach gefragt, wie die Nutzerinnen und Nutzer die Ausstattung und die angebotenen Dienstleistungen wahrnehmen und bewerten. Ohne die möglichst objektive Messung der Benutzerzufriedenheit ist eine Leistungsmessung unmöglich, denn die gemessene Leistung bliebe dann ein abstrakter Wert auf einer Messskala ohne Bezug zum Auftrag der Bibliothek.

In den letzten Jahren wurden zahlreiche nationale und internationale Projekte zur Leistungsmessung initiiert, u. a. die internationalen Richtlinien zur Leistungsmessung in wissenschaftlichen Bibliotheken der IFLA, das vom Bundesministerium für Bildung und Forschung geförderte Projekt „Controlling und Marketing in wissenschaftlichen Bibliotheken“ (COMBI), das DFG-Projekt „Kostenmanagement für Hochschulbibliotheken“, das nordrhein-westfälische Projekt „Betriebszahlen für Hochschulbibliotheken“ und der Bibliotheksindex (BIX), dessen Indikatorenraster zudem einen Leistungsvergleich zwischen Bibliotheken erlaubt.[31]

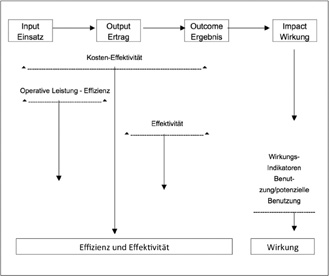

Leistungsmessung wird häufig auch um den Aspekt der Wirkungsmessung ergänzt. Den konzeptionellen Rahmen hierfür zeigt Abb. 8.

Konzeptioneller Rahmen für bibliothekarische Leistungsmessung.[32]

6 Verknüpfung von Hochschul- und Bibliotheksrankings

Insgesamt wird aus diesen Überlegungen deutlich, dass es aussagefähige „Bibliotheksindikatoren“ in möglichst allen Hochschulrankings geben sollte, die von den Hochschulleitungen intensiv genutzt werden. Die Untersuchung hat gezeigt, dass solche bibliotheksfachlich relevanten Indikatoren bislang nur beim CHE-Hochschulranking explizit in Erscheinung treten.

Eine erste, sehr naheliegende Forderung besteht also darin, dass die Bibliotheken mit den übrigen Anbietern von Hochschulrankings den Dialog suchen und für die Relevanz und den Nutzen von „Bibliotheksindikatoren“ werben. Aus Abb. 8 wird deutlich, dass die Leistungen der Bibliotheken sich stets in einer Wirkung manifestieren, die über geeignete Indikatoren darstellbar gemacht werden sollte. Eine Wirkung des Subsystems Bibliothek kann bei der Leistungsmessung von Hochschulen als Input dargestellt werden, der zu einer bestimmten Wirkung der Hochschule beiträgt. Die beiden Systeme Bibliothek und Hochschule sind also miteinander vernetzt und die Mittelausstattung der Bibliothek hat beispielsweise einen (indirekten) Effekt auf die Wirkungsindikatoren der Hochschule. Man würde also erwarten, dass eine hohe Qualität bibliothekarischer Leistung mit einem guten Abschneiden der Hochschule in Hochschulrankings korreliert. Folglich gibt es in den Hochschulen ebenfalls interessierte Gesprächspartner, um für die Aufnahme von „Bibliotheksindikatoren“ in Hochschulrankings zu werben. Schließlich stehen die Hochschulleitungen häufig in enger Verbindung zu den Anbietern von Rankings, um über die Auswahl und Gewichtung des Indikatorenrasters zu diskutieren oder über gezielte Einzelauswertungen weitergehende Erkenntnisse zu gewinnen.

Aber auch die umgekehrte Richtung eines Know-how-Transfers von den Hochschulrankings zu den Bibliotheksrankings eröffnet interessante Perspektiven. Bekanntlich konnte der Fortbestand des BIX für das Berichtsjahr 2014 nur knapp gesichert werden und es schließt sich im Frühjahr 2015 eine bibliothekspolitische und bibliotheksfachliche Diskussion an, wie das Indikatorenraster des BIX künftig aussehen soll und ob Elemente eines Qualitätsmanagements in dieses Instrument des Leistungsvergleichs aufgenommen werden sollten.[33] Abschnitt 5 machte deutlich, dass aus Sicht des Autors eine Verknüpfung von Leistungsmessung mit den Zielsystemen von Bibliothek und Hochschule zwingend ist, da durch die Hochschulleitungen das Erbringen einer bestimmten Qualität und der Nachweis einer bestimmten Wirkung gefordert werden. Sollte der BIX also um Indikatoren erweitert werden, die sich nicht nur auf das Messen von Input und Output beschränken, lohnt möglicherweise wiederum der Dialog mit den Anbietern des CHE-Hochschulrankings. Wenn dort Studierende u. a. die Verfügbarkeit der im Studium benötigten Literatur, den Medienbestand, die Beratungs- und Recherchequalität, die Verfügbarkeit von Arbeitsplätzen und die Öffnungszeiten bewerten, so ist dies sicher noch keine ausgefeilte Wirkungsmessung. Aber die Übernahme solcher und ähnlicher weiterer Indikatoren, zumal wenn sie auf Befragungen von Nutzergruppen basieren, kann ein vielversprechender Ansatz sein, den BIX um qualitative Indikatoren zu erweitern und damit sinnvoll zu ergänzen.

About the author

Michael Porzberg

Michael Porzberg:

michael.porzberg@ulb.hhu.de

© 2015 by De Gruyter

Articles in the same Issue

- Frontmatter

- Aus den Verbänden

- Deutscher Bibliotheksverband fordert rechtliche Sicherung der E-Book-Ausleihe für öffentliche Bibliotheken

- Themenheft: Leistungsvergleiche

- Zwischen Leistungsvergleich und Qualitätsentwicklung. Ergebnisse des Round Table „Chancen und Risiken von Leistungsvergleichen für Bibliotheken“ im Herbst 2014

- Bibliotheken auf dem Prüfstand

- Leistungsvergleiche als Instrument der Hochschulsteuerung: Ansätze, organisatorischer Kontext und Unterstützung des Steuerungshandelns

- Einer für alle? – Gemeinsames Befragungsdesign für vier FH-Bibliotheken in NRW im Leistungsvergleich

- Warum die Leistungen von Bibliotheken vergleichen?

- Weniger, aber besser?

- Die Verhältnisse sind unterschiedlich, ein normierter Vergleich macht keinen Sinn. Ein Statement zum BIX.

- Governance und Qualitätsmanagement in Bibliotheken

- Zukunftswerkstatt

- Von der Informationskompetenz zur Kulturzugangskompetenz

- Notizen

- Digitalisierung vergriffener Werke: Rahmenvereinbarung unterzeichnet, Clearingstelle im Aufbau

- Veranstaltungen

- 19. Verbundkonferenz des Gemeinsamen Bibliotheksverbundes (GBV)

- Termine

- Termine

Articles in the same Issue

- Frontmatter

- Aus den Verbänden

- Deutscher Bibliotheksverband fordert rechtliche Sicherung der E-Book-Ausleihe für öffentliche Bibliotheken

- Themenheft: Leistungsvergleiche

- Zwischen Leistungsvergleich und Qualitätsentwicklung. Ergebnisse des Round Table „Chancen und Risiken von Leistungsvergleichen für Bibliotheken“ im Herbst 2014

- Bibliotheken auf dem Prüfstand

- Leistungsvergleiche als Instrument der Hochschulsteuerung: Ansätze, organisatorischer Kontext und Unterstützung des Steuerungshandelns

- Einer für alle? – Gemeinsames Befragungsdesign für vier FH-Bibliotheken in NRW im Leistungsvergleich

- Warum die Leistungen von Bibliotheken vergleichen?

- Weniger, aber besser?

- Die Verhältnisse sind unterschiedlich, ein normierter Vergleich macht keinen Sinn. Ein Statement zum BIX.

- Governance und Qualitätsmanagement in Bibliotheken

- Zukunftswerkstatt

- Von der Informationskompetenz zur Kulturzugangskompetenz

- Notizen

- Digitalisierung vergriffener Werke: Rahmenvereinbarung unterzeichnet, Clearingstelle im Aufbau

- Veranstaltungen

- 19. Verbundkonferenz des Gemeinsamen Bibliotheksverbundes (GBV)

- Termine

- Termine