„Step away from the Computer!“

Abstract

Linguistic research frequently requires the categorization of language phenomena in corpus data (annotation). Since those may occur plentifully, a partial or full automation of the annotation process appears attractive. The filtering and recombination of existing annotation layers seems to further provide an elegant solution to the deduction of higher-level annotations. In this contribution, we show at the example of German split particle verbs that this approach results in a number of linguistic, technological, and epistemological challenges related to the precise definition of the various models employed and their interfaces. We argue that the manual annotation of corpus data is not merely a preprocessing task, but is itself an epistemological process central to the development of linguistic theory. We discuss why machine-based language processing can neither mimic nor replace this process; why it can generally not reach a level of precision that would be suitable for linguistic research without further integration, adaptation, and manual correction; and how its blind application systematically skews results in crucial areas of research. We close with the suggestion of several best practice approaches which help to prevent and resolve incompatibilities and delays arising from common problems of corpus-based language modeling.

1 Einleitung

Viele linguistische Fragestellungen erfordern die Gegenüberstellung und den Vergleich verschiedener Phänomene oder Varietäten anhand kontextualisierter Sprachproduktions-, d. h. Korpusdaten (Biber und Jones 2009). Der Vergleich kann durch verschiedene Korpora geschehen oder durch die Einteilung eines Korpus in mehrere Subkorpora, bspw. anhand von Metadaten. So können etwa Texte von L1- und L2-Sprecher:innen verglichen werden, gesprochene und geschriebene Daten, oder Texte aus dem 19. und dem 20. Jahrhundert. Vergleichen kann man, was man möchte und was die Fragestellung erfordert. Einige Analysen, z. B. die Suche nach dem Vorkommen bestimmter Chunks, können direkt auf der Textebene durchgeführt werden. Die meisten Forschungsfragen aber erfordern eine Kategorisierung der Daten, also eine Abstraktion von der Textebene, z. B. nach Wortarten, syntaktischen oder semantischen Kategorien oder satz- und textinternen Abhängigkeiten. Wenn die Kategorisierung direkt im Korpus hinzugefügt wird, spricht die Korpuslinguistik von Annotation – andere Disziplinen verwenden zuweilen auch die Begriffe Datenkodierung oder Auszeichnung. Da jeder Einzelfall eines Phänomens kategorisiert werden muss und es sich um viele Tausend oder gar Millionen Fälle handeln kann, liegt der Griff zu automatischen Analysetools nahe, die in der Computerlinguistik – überwiegend zu anderen Zwecken – entwickelt werden. Diese lassen sich oft in eine Pipeline integrieren, die mehrere aufeinander aufbauende Analyseschritte zusammenfasst. Somit können Textdaten in eine Abfolge von maschinellen Analysen eingegeben werden, um als syntaktisch, morphologisch und vielleicht sogar diskursstrukturell geparste, lemmatisierte und teilweise (z. B. nach Komplexität oder Worthäufigkeit) quantifizierte Forschungsdaten ausgegeben zu werden.[1]

Gut wäre es nun, wenn am Ende der Pipeline die Sprachdaten fertig, vollständig und richtig analysiert vorlägen, sodass sie z. B. zur direkten Weiterverarbeitung in statistischen Modellen geeignet wären oder sogar abgeschlossene Analysen darstellten. Die Praxis zeigt jedoch, dass die Präzision der Ausgabe in der Regel enttäuschend ist und nicht für forschungslinguistische Zwecke ausreicht. Wir werden zeigen, warum das nahezu zwingend der Fall ist und es eher überraschen muss, wenn die maschinelle Verarbeitung von Korpusdaten akzeptable Ergebnisse liefert.

Darüber hinaus lockt als Weiterführung des Verkettungsansatzes ein vermeintliches Potential, die Annotation neuer Phänomene, d. h. solcher, für deren Analyse kein spezielles Tool vorliegt, ohne großen Aufwand aus der Verknüpfung vorhandener Annotationsebenen zu generieren. In diesem Beitrag wollen wir zeigen, dass auch diese Annäherung trügerisch ist, weil sie mit einer Vielzahl wichtiger und schwer zu überbrückender linguistischer, epistemologischer und technischer Schwierigkeiten einhergeht. Wir argumentieren, dass es sich dabei nicht um eine zufällige Ansammlung von ungelösten Fragen handelt, sondern um einen Komplex verwandter Herausforderungen, die ihren Kern darin teilen, dass sie allesamt Modellierungsprobleme sind. Das ist inhärenten Eigenschaften der Sprache geschuldet, z. B. struktureller Ambiguität und Produktivität, und der daraus erwachsenden Modellkomplexität, deren Integration in ein einziges Standardmodell unmöglich ist – so können auch linguistische Expert:innen keine abschließende und allgemeingültige Klassifizierung selbst von basalen Kategorien wie Wortarten vornehmen. Im Forschungskontext sind darum alle Entscheidungen anhand von forschungsfragen- und theoriespezifischen Richtlinien zu treffen. Die Anwendung dieser Richtlinien auf natürliche Sprachdaten, eben die Annotation, fördert jedoch sogleich ihre Grenzen zu Tage. Damit erlaubt – und erzwingt – sie die Reflexion der Kategorien selbst. Manchmal handelt es sich dabei lediglich um eine Explikation der Episteme, die eine linguistische Theorie bereits implizit vorgibt. Häufig treten aber bei der Einzelfallklassifizierung gerade die Widersprüche und Interaktionen ihrer Kategorien hervor, sodass aus dem Annotationsprozess selbst eine Schärfung der linguistischen Theorie entspringt. Es handelt sich somit bei der Annotation um eine dialektische Auseinandersetzung zwischen dem Allgemeinen und dem Besonderen in der Sprache, d. h. einen Erkenntnisprozess. Dieser kann von der Maschine weder vorweggenommen noch unter Berücksichtigung von Idiosynkrasien und konkreten Dynamiken in neuen Daten nachvollzogen werden, da Maschinen prinzipiell keine sinnentnehmende Analyse linguistischer Strukturen vornehmen können, sondern lediglich mehr oder weniger konkrete Muster projizieren.

Aus diesen beiden Erkenntnissen – a) die Kategorisierung linguistischer Daten (Annotation) ist linguistische Modellierung, somit genuine Forschungsarbeit, und b) die maschinelle Kategorisierung ist keine Automatisierung dieses Prozesses – ergeben sich Komplikationen bei der Erweiterung und Nachnutzung von vorhandenen Korpora und den darin enthaltenen Annotationen.

Zusätzlich zur linguistischen Komplexität handelt es sich bei der Annotation um ein komplexes Problem der Abbildung unterschiedlicher und oftmals zahlreicher Modelle aufeinander (z. B. linguistischer, mathematischer, technischer, usw., s. a. Shadrova, Klotz et al., erscheint). Das erfordert sowohl die Modellierung jedes Bestandteils als auch eine möglichst vollständige Definition aller Schnittstellen. Die Vielfalt der möglichen Modelle und Schnittstellen potenziert sich hier zu einem de facto unbegrenzten Raum der Realisierungsmöglichkeiten. Das bedeutet jedoch keinesfalls, dass die Umsetzungsentscheidungen irrelevant wären: Gerade weil es keine theorieneutralen, finalen oder allgemeingültigen Lösungen geben kann (jedenfalls nicht solche, die sich noch in einer linguistisch nützlichen Abstraktionsebene bewegen), ist es erforderlich, für das jeweilige Forschungsinteresse zu definieren, wie verschiedene Aspekte der Daten- und Analysemodelle zusammenarbeiten sollen. Das betrifft neben den linguistischen Fragen auch Anforderungen der Datenverknüpfung, wenn z. B. auf verschiedenen linguistischen Ebenen gearbeitet werden soll; der Quantifizierbarkeit, die gewisse Anforderungen des gewählten mathematischen Modells voraussetzt; und des Datenexports, um eine Extraktion einzelner Elemente und Faktoren und ihre Darstellbarkeit zu gewährleisten. Während das zuvor Beschriebene ein Problem der linguistischen Theorie ist, ergibt sich spätestens an dieser Stelle auch eine erhöhte technische Komplexität, die viele Entscheidungen mit wichtigen Folgen für die Erweiterbarkeit und Datennachhaltigkeit erfordert. Die korpuslinguistische Herausforderung liegt darum nicht primär darin, wie man linguistische Phänomene geschickt aus Korpusdaten herausfiltern kann, sondern vielmehr, wie sich die gewünschte Abstraktionsebene überhaupt erst einmal sinnvoll auf die Daten abbilden lässt.

Wir vertreten in diesem Artikel den Standpunkt, dass diese Modellierungsarbeit den Kern und die Einzigartigkeit der korpuslinguistischen Perspektive ausmacht. Ihre Auslassung oder Verkürzung durch eine blinde Verkettung maschineller Annotationen verschenkt nicht nur viele Erkenntnisse und somit Potentiale für die Entwicklung der linguistischen Theorie, sondern liefert auch und gerade an neuralgischen Punkten systematisch falsche Ergebnisse. Wir demonstrieren dafür am Beispiel der Analyse von Partikelverben in einem historischen und einem multilingualen Kontext, welche Probleme sich bei der teilmaschinellen Annotation durch die Verkettung von Grundlagenannotationen (Tokenisierung, Wortartentagging, Dependenzen) ergeben und wie diese Probleme im Wesen der maschinellen Analyse von natürlicher Sprache begründet sind. Wir zeigen dann, wie sich schon vermeintlich einfache Kategorisierungen in natürlichsprachlichen Daten widerspenstig zeigen und demonstrieren, wie Entscheidungsprobleme dieser Art sich als Abbildungsprobleme durch die gesamte Korpus- und Analysearchitektur ziehen. Wir argumentieren, dass gerade dieser Prozess der vielfältigen Abbildungsentscheidungen Klarheit und Erkenntnis über die Modelle, ihr Zusammenspiel und ihre Grenzen erzeugt und stellen abschließend Best-Practice-Ansätze zur Modellstruktur und Datenbeherrschbarkeit vor, die als Gerüst für die Strukturierung und nachvollziehbare Gestaltung dieses Erkenntnisprozesses dienen.

2 Beispiel: Analyse von Partikelverben

Wir illustrieren unsere Überlegungen am Beispiel von Partikelverben, d. h. komplexen Verben, deren Partikel betont und in entsprechenden syntaktischen Kontexten getrennt wird (z. B. mitmachen, rüberlaufen). Weitere Eigenschaften werden wir im Folgenden ausführlich besprechen.[2] Partikelverben stehen hier stellvertretend für jedes linguistische Phänomen, das nicht rein auf der Oberflächenzeichenfolge gesucht werden kann. Sie eignen sich aus verschiedenen Gründen zur Illustration gut:[3] Sie sind häufig und es gibt (mindestens) vier Aspekte, die Modellierungsentscheidungen mit weitreichenden Folgen für ihre Analyse erfordern: die Distanzstellung, die möglichen Kategorien der Partikeln, ihre Semantik und ihre Produktivität. Hier reißen wir diese vier Aspekte kurz an, in den weiteren Abschnitten werden wir sie wieder aufgreifen.

Partikelverben kommen in V-letzt-Sätzen zusammengeschrieben und in V1- und V2-Sätzen in Distanzstellung vor, siehe (1).[4] Dies ist oft als ein Problem bei der Lemmatisierung und Wortartannotation beschrieben worden (Volk et al. 2016).

|

(1) |

a. |

Man muss aber mehrere Aspekte untersuchen, bevor man mit dem Studium anfängt.[5] |

|

|

b. |

Schon im jugendlichen Alter fangen Mädchen und Jungs an Straftaten zu begehen[6] |

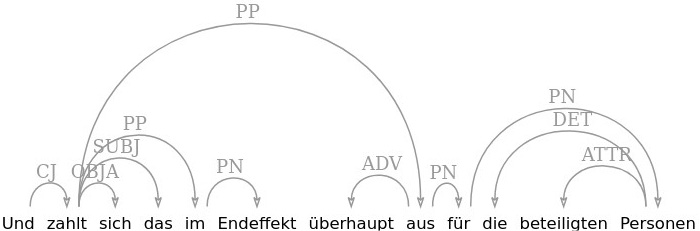

Um die Partikelverben in Distanzstellung lemmatisieren zu können, muss die Partikel identifiziert werden, oft über homonyme Präpositionen oder andere Elemente hinweg (Deutsche Sätze können lang sein!). Fehler in der Klassifikation der Partikeln, wie in Abbildung 1, wo zu fälschlich als Verbpartikel getaggt wird (PTKVZ nach dem Stuttgart-Tübingen Tagset, Schiller et al. 1999), verursachen dann Probleme bei der Lemmatisierung und allen weiteren Verarbeitungsschritten, siehe Abschnitt 2.2.

zu in Verwendung als Präposition, falsch getaggt als Partikelverbzusatz

Ein anderes – vermutlich schwierigeres – Problem ist, dass gar nicht eindeutig ist, welche Elemente als Partikeln für Partikelverben gelten können (siehe Lüdeling 2001, für einen Überblick und eine Diskussion der Ansätze): Es gibt Literatur, die eine feste Menge an Partikeln annimmt (an, auf, ab etc.); so geht bspw. Köper (2018) vor. Andere Ansätze betrachten auch Verben und Nomina in Strukturen wie spazieren ⋅ gehen oder klavier ⋅ spielen. Wieder andere (so bspw. viele deutsche Grammatiken) nehmen eine offene Gruppe an, die aber von Adverbien und Präpositionen abgeleitet ist. Auch wenn es hier am offensichtlichsten ist: Das Thema betrifft nicht nur die Distanzstellung, sondern auch die Zusammenschreibung von (Kandidaten für) Partikelverben in Adjazenzstellung. Darauf kommen wir in Abschnitt 2.2 zurück.

Manchmal wird als ein Kriterium dafür, ob ein Element als Verbpartikel gezählt werden soll, die Nichttransparenz des Partikelverbs angeführt (so wurde bspw. in Grammatiken – mindestens bis zur Rechtschreibreform – zwischen sitzen bleiben im Sinne von ‚weiterhin sitzen‘ und sitzenbleiben im Sinne von ‚eine Klasse wiederholen‘ unterschieden – im ersten Fall wäre sitzen keine Partikel, im zweiten Fall schon). Das Kriterium ist in vielerlei Hinsicht problematisch (siehe bspw. Felfe 2012; Köper 2018; Lüdeling 2001) und vor allem nicht eindeutig anwendbar. Eines der Probleme dabei ist, dass es neben (vielen) lexikalisierten Einzelfällen viele produktive Muster[7] gibt und dadurch neue Partikelverben gebildet werden können.

2.1 Verwendete Korpora

Hier wollen wir kurz die verwendeten Korpora Falko und RIDGES vorstellen.

Falko[8] ist ein Korpus, das vergleichbar erhobene argumentative Essays von fortgeschrittenen Lerner:innen des Deutschen als Fremdsprache (L2) und deutschen Muttersprachler:innen (L1) enthält. Falko wird zur Analyse unterschiedlicher Erwerbsphänomene genutzt. Falko ist tief annotiert, unter anderem hat es zwei Zielhypothesenebenen (Lüdeling und Hirschmann 2015), eine nur zur orthographischen Normalisierung des Ausgangstexts und eine als L1-ähnliche Wiedergabe/Korrektur des Geschriebenen, und enthält grammatische Annotationen auf verschiedenen Ebenen (Hirschmann et al. 2022; Reznicek, Lüdeling und Hirschmann 2013).

RIDGES ist ein diachrones Korpus, das Kräutertexte aus der Zeit zwischen 1482 und 1914 enthält.[9] Darunter sind vor allem Ausschnitte aus Kräutermonographien, aber auch Vorworte zu Kräuterbüchern, wissenschaftliche Texte etc. RIDGES enthält neben der diplomatischen Tokenebene zwei Normalisierungsebenen und etliche grammatische und inhaltliche Annotationsebenen (Odebrecht et al. 2016; Schnelle et al. 2022; Uyanık et al. 2025). Wichtig für die Diskussion unten ist, dass die automatische Analyse auf einer manuell erstellten Normalisierungsebene durchgeführt wird, die die gegenwartsdeutsche Schreibung enthält. Das heißt, die Probleme, die unten angesprochen werden, sind nicht auf historische Schreibvarianten zurückzuführen.

Falko wurde gesammelt, um Spracherwerbsmuster und ggf. Einflüsse der L1 bei fortgeschrittenen Lerner:innen des Deutschen als Fremdsprache untersuchen zu können. Das RIDGES-Korpus soll zur Analyse der sich entwickelnden wissenschaftlichen Register im Deutschen dienen. Wir haben diese beiden Korpora gewählt, weil sie nicht (schriftliche, editierte) sogenannte Standardsprache enthalten. Damit sind sie weit entfernt von den Trainingskorpora verschiedener Annotationstools. Für die Fragestellungen, für die diese Korpora erstellt wurden – Spracherwerb und Sprachwandel – ist essentiell, dass man genau weiß, welche Fälle von einem Werkzeug wie behandelt werden. Die angesprochenen Punkte gelten aber genauso für „Standardsprache“.

Beide Korpora können in verschiedenen Formaten ausgewertet werden. Wir nutzen hier für die Darstellung oft das Suchwerkzeug ANNIS (Krause et al. 2022).

2.2 Automatische Analyse

Keines unserer beiden Korpora enthält explizite Partikelverbannotationen.[10] Beide liegen aber in einer Multi-Layer-Architektur mit zahlreichen anderen Annotationsebenen vor. Darin enthalten ist natürlich eine Tokenisierung, in diesem Fall eine Aufteilung des Fließtextes in graphemische Wörter und Satzzeichen, eine Lemmatisierung und ein Wortartentagging sowie zum Teil syntaktische Dependenzen. Welche Wege stehen uns offen, wenn wir nun versuchen wollen, auf Basis der vorliegenden Annotationen automatisch alle Partikelverben zu extrahieren?

Vielleicht wäre es am einfachsten, wenn wir anhand einer Wortliste abgleichen könnten, ob es sich bei einem Verb um ein Partikelverb handelt. Das setzte eine annähernd vollständige Liste aller Partikelverben voraus, die es aufgrund der hohen Produktivität von Partikelverbbildung gar nicht geben kann. Nehmen wir aber für den Moment einmal an, uns läge solch eine Wortliste vor.

Dann würden wir die Partikelverben in Adjazenzstellung, die auf dieser Liste stehen, auf Basis der automatischen Lemmatisierung und Wortartenanalyse durch den Treetagger (Schmid 1999; Schmid 2008) finden können,[11] so bspw. anbieten in 2a oder darbieten in 2c. In 2b und 2d werden die Lemmata aber aufgrund der Distanzstellung nicht gefunden – der Treetagger kann sie nämlich nicht selbstständig zusammenfügen.

syntaktischer Parse, der die Abhängigkeit der Partikel an vom Verbstamm biet darstellt

aus in Verwendung als Partikel des Verbs auszahlen, falsch getaggt als Präposition

|

(2) |

a. |

In der Regel arbeiten sie bei Firmen, die nur kurzfristige Vertraege anbieten[12] |

|

|

b. |

Das Studium bietet viele Fachkombinationen an[13] |

|

|

c. |

oder, falls nur eine Art von der Gattung vorhanden i |

|

|

d. |

Endlich bietet Viscum album noch eine andere Art von Polyembryonie dar[15] |

Obwohl wir wissen, dass anbieten in 2b ein Partikelverb ist, und obwohl der Tagger korrekt erkannt hat, dass an eine Partikel ist (getaggt als PTKVZ), ist es uns auf Basis der vorliegenden Daten nicht möglich, die korrekte Lemmatisierung zu extrahieren. Obwohl wir mit unserer Strategie einige Partikelverben korrekt identifizieren konnten, erreichen wir unser Ziel einer Extraktion aller Partikelverblexeme nicht. Dafür müsste zunächst die Lemmatisierung korrekt zusammengefügt werden, wofür wir zusätzlich die Information über die Abhängigkeit von Verbbasis und Partikel brauchen.

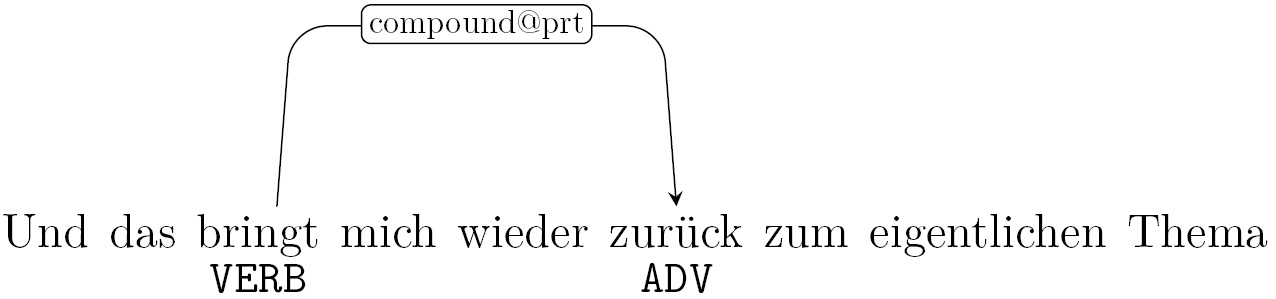

Glücklicherweise enthält eines unserer Korpora (Falko) diese Information, es ist nämlich syntaktisch geparst. In ungeparsten Korpora wie RIDGES müssten Nachverarbeitungsschritte die Verbindung herstellen, was aufgrund der unterschiedlichen Sprachstufen durchaus schwierig sein kann. Abb. 2 zeigt den Parse zu 2b. Hier sieht man die Kante (Verbindungslinie) vom Verb biet zur Verbpartikel an.

Es ist uns hier also gelungen, mit Hilfe der syntaktischen Abhängigkeitsinformation die Partikel mit dem Verb zu verbinden und wir können auch produktive Neubildungen abbilden, sodass wir jetzt sogar ohne unsere zunächst angedachte Wortliste auskommen. Zu einem gewissen Anteil haben wir mit unserer Suche nach abhängigen Partikeln den menschlichen Analyseprozess nachgestellt. Allerdings hängt unser Erfolg jetzt weiterhin davon ab, dass der Tagger die Partikeln richtig erkennt und zusätzlich davon, dass der Parser die Abhängigkeit richtig zuweist. Beides scheitert leider oft. (Fast) alle Verbpartikeln sind homograph mit anderen Elementen.[16] Abb. 3 und 4 zeigen, wie der Parser an der Zuweisung der Partikel aus scheitert, weil bereits der Tagger sie nicht richtig als solche erkannt hat.

syntaktischer Parse, der aus fälschlicherweise als Kopf einer PP darstellt

In diesem Fall kann man vermuten, dass der Tagger durch die Extraposition von für die beteiligten Personen verwirrt wurde, weil das PTKVZ-Tag eine höhere Wahrscheinlichkeit hat, am Ende eines Teilsatzes (also vor einem Satzzeichen) aufzutreten. Man erkennt, dass bereits kleine und im sprachlichen Sinn unauffällige Abweichungen von einer angenommenen Standardsyntax eine Schwächung der maschinellen Analyse bewirken. Noch schwieriger wird die automatische Erkennung bei sehr langen und eingeschobenen Sätzen, denn Tagger und Parser können entfernten Kontext nur bis zu einem gewissen Grad berücksichtigen, da bei vielen konkurrierenden Elementen die Wahrscheinlichkeit der Zuweisung zu jedem geringer wird. Dieses stochastische Prinzip konkurriert mit der sprachlichen Realität, die keine absolute Grenze für Fernabhängigkeiten vorsieht. Der lineare Abstand zwischen Verb und Partikel in Distanzstellung kann leicht Dutzende Token erreichen, bspw. in er isst die leckere Suppe, von der von gestern noch so viel übrig geblieben ist, doch noch schnell auf. In solchen Fällen ist es für Tagger fast unmöglich, den Zusammenhang korrekt zu ermitteln, da sie nicht hierarchisieren, somit also nicht erkennen, dass die vielen Token im Relativsatz zwischen isst und auf zu einer anderen Ebene gehören. Parser wiederum hierarchisieren zwar, tun das aber auf Basis von Wortartenannotationen – die maschinelle Katze beißt sich in den Schwanz.

Die Beispiele in 3 zeigen, dass die Fehlmarkierung von aus als Präposition keine grundlegend fehlerhafte Eigenschaft des Taggers ist: Es ist durchaus plausibel, dass nahestehende Präpositionen oder Adjektive eben keine Verbpartikeln sind, sondern andere Rollen in der Argumentstruktur einnehmen.

|

(3) |

a. |

[…] wenige geben sich mit einem einfachen Job zufrieden, oder gehen auf ihrer „Karriereleite“ eine Stufe wieder runter.[17] |

|

|

b. |

[…] Das ſafft von dem kraut Borrich / miſch mit zucker vnd trincks[18] |

Ein weiteres Problem bei unserer automatischen Annotation von Partikelverben liegt in der Schreibung. Insbesondere in nicht-standardsprachlichen und sprachdynamischen Daten hängt die Parser- und Taggerpräzision in besonderem Maß von den Tokenisierungseigenschaften, nämlich der Getrennt- und Zusammenschreibung von Wörtern, ab. Da diese historisch zuweilen sehr uneinheitlich ist, erkennt unser Modell den Fall 4a aus dem RIDGES-Korpus, den Fall 4b hingegen nicht, obwohl keine Distanzstellung vorliegt:

|

(4) |

a. |

[…] gegen Nacht wann die Sonn vndergangen i |

|

|

b. |

[…] Nachtſchatten / Cardamomum ynn latein genant / gep |

Ähnliches ergibt sich durch Schreibvarianten. In 5a (produziert von einer deutschen Muttersprachlerin) wird antun in einem Adjazenzkontext getrennt geschrieben. Hier hat der Tagger an als PTKVZ annotiert und getan als Partizip, sodass es vielleicht eine (syntaktische) Möglichkeit gibt, beide zusammenzufügen, aber das müsste dann in einem späteren Schritt geschehen. In 5b wird dinge klein geschrieben und plausibel vom Tagger als Form eines möglichen Verbs dingen erkannt, sodass es dann ein Partikelverb aufdingen geben müsste. In 5c schließlich wird stadt getrennt und falsch geschrieben. In all diesen Fällen muss interpretiert werden. Ähnliches ergibt sich bei diachronen Daten mit sich veränderten Schreibkonventionen.

|

(5) |

a. |

[…] die Gemeinheiten, die ihnen an getan wurden, rächen zu können[21] |

|

|

b. |

[…] die uns aufmerksam machen auf dinge wie[22] |

|

|

c. |

[…] Kommunikation mit nicht ernsthaften Menschen kann nur dann stadt finden, wenn[23] |

In allen Fällen transportiert sich die Ungenauigkeit von einer automatischen Annotation, etwa der Tokenisierung streng nach Spatien oder Satzzeichen, auf die nächste Ebene, z. B. das Wortartentagging. Zuletzt greift der Parser die vorherigen Analysen auf und führt sie folgerichtig weiter, was schließlich für unseren Gebrauch zu Problemen bei der Zusammenfügung und Extraktion der Elemente auf Lemmaebene führt.

Eine Besonderheit scheint hier bei generativen Sprachmodellen wie GPT (OpenAI et al. 2023) vorzuliegen, das in seiner Benutzeroberfläche (ChatGPT) die Anfrage kompletter Analysen ohne Unterteilung in verschiedene Analysebenenen zu erlauben scheint. So kommt folgendes Gespräch mit ChatGPT 4.0 zustande (angefragt am 11.10.2024):

|

(6) |

a. |

Anfrage: „Führe beim folgenden Satz alle getrennten Verben auf: er isst die leckere Suppe, von der von gestern noch so viel übrig geblieben ist, doch noch schnell auf“ |

|

|

|

ChatGPT: „Im Satz „er isst die leckere Suppe, von der von gestern noch so viel übrig geblieben ist, doch noch schnell auf“ gibt es zwei trennbare Verben: |

|

|

|

1 isst auf (Grundform: „aufessen“) |

|

|

|

2 ist übrig geblieben (Grundform: „übrigbleiben“) |

|

|

|

Das erste Verb „aufessen“ wird im Satz in seiner Präsensform „isst auf“ verwendet, und das zweite trennbare Verb „übrigbleiben“ tritt hier in der Perfektform „ist übrig geblieben“ auf.“ |

Auch GPT scheitert allerdings an längeren Sätzen an der Zahl der möglichen Zuweisungsobjekte für für das flektierte Verb und die Partikel (Bsp. 7a, angefragt am 21.10.2024.). Zusätzlich sind die Ergebnisse nicht verlässlich replizierbar. So liefert ChatGPT bei unserer Wiederholung derselben Anfrage eine andere Ausgabe, siehe Beispiel 7b).[24] Beide Antworten sind natürlich falsch, weil in beiden das Verb aufspringen nicht erkannt wird. Im ersten Fall gibt es sogar zwei Fehler: ein falsch nicht erkanntes Partikelverb, aufspringen (false Negative, s. u.) und ein fälschlich erkanntes, aufwedeln (false Positive, s. u.).

|

(7) |

a. |

Anfrage: „Welche getrennten Verben gibt es im folgenden Satz: Die Frau springt, schockiert vom Hund, der unerwartet laut losbellt, mit den Armen wedelnd auf und ruft ihre beste Freundin an“ |

|

|

|

ChatGPT: „Im vorliegenden Satz sind die getrennten Verben wie folgt zu identifizieren: auf (in „auf…wedelnd“) |

|

|

|

an (in „ruft…an“) |

|

|

|

Das Verb „auf“ wird im Zusammenhang mit „wedeln“ verwendet, was darauf hindeutet, dass die Bewegung und die Handlung durch die abgetrennte Partikel spezifiziert wird. Das Verb „rufen“ hingegen zeigt die vollständige Trennung durch die Partikel „an“, was die Zielrichtung der Handlung verdeutlicht. Diese Trennung der Partikel von den zugehörigen Verben ist charakteristisch für die deutsche Sprache, insbesondere bei der Verwendung von Trennungsverben, die in unterschiedlichen syntaktischen Kontexten variieren können.“ |

|

|

b. |

„In dem Satz gibt es ein getrenntes Verb: |

|

|

|

anrufen (in „ruft ihre beste Freundin an“) |

|

|

|

Hier wird die Partikel „an“ vom Verb „rufen“ abgetrennt. Das Verb „auf“ in „auf und“ ist hingegen keine Partikel, sondern Teil einer Phrase.“ |

Dieses Beispiel zeigt, dass auch generative Sprachmodelle keine zuverlässig vollständigen oder linguistisch korrekten Ergebnisse liefern, selbst wenn es so wirken kann, als würden sie verstehen, was sie tun. Tatsächlich arbeitet jedoch jede maschinelle Analyse – auch die von ChatGPT (s. Abschnitt 3.1) – mit einer Aneinanderreihung von Analysefunktionen. Daraus ergibt sich eine wechselseitige Abhängigkeit mit zwingenden Folgefehlern, sobald ein Teil der Pipeline unpräzise arbeitet. Warum aber ist das auch nach jahrzehntelanger Forschung im Bereich der Computerlinguistik weiterhin der Fall? Wäre es nicht möglich, präzise arbeitende linguistische Analysetools zu entwickeln?

2.3 Grenzen des linguistischen Modells

Hier kommen wir zurück auf das Problem, dass es überhaupt nicht unstrittig ist, was genau als Partikelverb zählt und was nicht. Wie in Abschnitt 2 bereits erwähnt, sind sich Linguist:innen nicht einig, wie genau sich Partikelverben von anderen Strukturen abgrenzen und was als Verbpartikel zählen soll. Es muss also immer eine Entscheidung getroffen werden. Diese ist zunächst unabhängig vom Tool und leitet sich aus der jeweiligen Fragestellung und dem grammatischen Modell ab. Für die Erstellung eines synchronen Lexikons wie das GermaNet kann hier bspw. eine ganz andere Entscheidung nötig sein (siehe Hoppermann und Hinrichs 2014) als für die Analyse von Lernerdaten (siehe zum Beispiel Lüdeling, Hirschmann und Shadrova 2017). Grammatiken und allgemeine Abhandlungen können in gewisser Weise vage bleiben und lediglich zentrale Beispiele für Partikelverben auflisten. Tagger und Parser können das nicht – sie müssen in jedem Fall eine Entscheidung treffen.

|

(8) |

a. |

Schwarzsehen oder etwas illegales aus dem Netz runter Laden würde ich eigentlich als eine Kriminalität bezeichnen[25] |

|

|

b. |

dass die Kriminalität runter gebracht werden müssen[26] |

|

|

c. |

die Frauen total gleichberechtigt mit den Männer zu machen und die Männer runterzuführen[27] |

|

|

d. |

Die kriminellen Leute schlagen Leute runter, die Stehlen usw.[28] |

In 8a, zum Beispiel, müsste eine Entscheidung zu runter Laden getroffen werden.[29] Ist es ein Partikelverb, auch wenn es getrennt geschrieben und das eigentliche Verb hier groß geschrieben ist? Die meisten aktuellen Tokenisierer für das Deutsche trennen an Spatien. Dann würde runterführen in 8c als einziges klares Partikelverb gezählt, die anderen Fälle wohl nicht. Wäre das eine angemessene Beschreibung des Wortbildungsverhaltens hier? Wenn man sich für die Produktivität in der Wortbildung bei Lerner:innen des Deutschen als Fremdsprache interessiert, sollten 8a und 8b unbedingt mitbetrachtet werden.[30]

Wenn man sich für die Schreibung interessiert, wäre es vielleicht die richtige Entscheidung, runter und laden getrennt zu analysieren. Interessant ist in diesem Zusammenhang Beispiel 8d, wo sich Verb und Partikel in Distanzstellung befinden: Hier kann die Schreibung keinen Hinweis geben – nur die linguistische Modellierung kann vorgeben, ob runterschlagen als Partikelverb klassifiziert werden soll. Auch wenn runter wahrscheinlich in allen Modellen als eine (mögliche) Verbpartikel zählen kann, zeigt sich schon an diesem Beispiel, wie sehr das linguistische Interesse und Modell auf der einen und die maschinelle Verarbeitung durch vorhandene Werkzeuge auf der anderen Seite auseinanderklaffen können.

Im Fall unpräzise arbeitender Modelle kann man, wenn man weiß, was man möchte, noch Nachverarbeitungsschritte einbauen. Wenn das linguistische Modell selbst unklar ist, ist es aber schwieriger. Wie oben beschrieben, wird in RIDGES das Wortartentagging auf der gegenwartsdeutschen Normalisierung durchgeführt. Das, was als Partikelverb gilt, kann sich jedoch über die Zeit verändern. Wenn man die Entwicklungen nachzeichnen möchte, muss man ein linguistisches Modell entwickeln, dass (a) der jeweiligen Sprachstufe gerecht wird und (b) Vergleiche ermöglicht.

Die Notwendigkeit und Grenzen einer linguistischen Modellierung zeigen sich auch an den Beispielen in 2.3. Soll darunð miſchen in 9a als Partikelverb gezählt werden? Die Schreibung können wir hier nicht heranziehen, Getrennt- und Zusammenschreibung haben sich erst entwickelt. Wir müssen aber bereits auf der Normalisierungsebene eine Entscheidung über Getrennt- oder Zusammenschreibung treffen – von dieser hängen dann weitere Analysen (Tokenisierung, Tagging, Lemmatisierung) ab. Das gilt dann genauso für die Distanzstellung in 9b. Wie oben für das Gegenwartsdeutsche beschrieben, müssen die Kriterien hier rein aus der linguistischen Modellierung kommen. In 9e haben wir das Problem, dass das (zusammengeschriebene) zuverstehen heute nicht als Partikelverb aufgefasst würde, sondern als Infinitivpartikel und verstehen, während das (genauso geschriebene) zubereiten heute als Partikelverb analysiert würde. Wir haben hier also nicht nur mit Unterschieden auf Ebene der Sprachdaten zu tun, sondern auch mit unterschiedlichen Kategorisierungsnormen und Systematisierungen. Wir können uns entscheiden, ob und wann wir ihnen folgen wollen. Das bedarf aber zunächst ihrer Reflexion und dafür eines Bewusstseins über ihre Existenz und Zusammenhänge, es gibt keine allgemein richtige Vorgehensweise.

|

(9) |

a. |

darnach ſol er den auſztruckẽ durch ain tůch vnd dañ darunð miſchen h |

|

|

b. |

Man miſche nun auch trockne Zwiebel, ge |

|

|

c. |

ſo wirdt das Saltz zu einem Waſſer werden / vnd vom |

|

|

d. |

bis die ſchwarze Schaale herunter i |

|

|

e. |

Dieſelben / weil ich ſie zu allerley handt⸗ griff zuverſtehen / vnnd gute Artzneyen zube⸗ reiten / gut vnd nutz erachtet[35] |

Dazu können wir mögliche adjektivische, verbale und nominale Elemente betrachten. In einigen Fällen werden solche Elemente als Verbpartikeln gezählt, wenn sie zusammen mit dem Basisverb eine nicht semantisch transparente Verbindung eingehen (wie in oben genanntem Beispiel sitzenbleiben). Aber wie wäre Nichttransparenz festzustellen? Vor allem, wie wäre sie automatisch in einem Vorverarbeitungswerkzeug festzustellen?[36] Köper (2018) und Bott und Schulte im Walde (2015) diskutieren automatisch durchzuführende Tests für die semantische Transparenz, aber auch diese können nicht von einem Tool zum Tokenisieren, Taggen oder Parsen durchgeführt werden, da sie auf einer vorherigen automatischen Analyse (nämlich dem Taggen und Parsen) beruhen. Das heißt, dass auch sie nicht definieren können, was Partikelverben sind, sondern aufbauen müssen auf anderen Entscheidungen. Was noch schwerer wiegt: Es gibt überhaupt keinen Grund zur Annahme, dass Partikelverben nicht auch transparent sein können. Durch produktive Muster werden ständig neue transparente Partikelverben gebildet. Warum sollte das bei Adjektiven, Nomen und Verben anders sein als bei anderen Erstgliedern? Hier wollen wir die Validität der einzelnen Analysen nicht diskutieren, sondern sagen: Jedes Tool nutzt eine linguistische Modellierung – oft, ohne diese genau zu spezifizieren. Für viele Variationsphänomene kann es ganz verschiedene Modelle geben – die Ergebnisse der Tools sind dann unterschiedlich. Man kann grundsätzlich nicht davon ausgehen, dass das Modell, das ein Tool nutzt, den eigenen Vorstellungen entspricht oder nah an den Anforderungen des eigenen Anwendungsfalls konzipiert ist.

3 Herausforderungen der linguistischen Modellierung und ihrer technischen Abbildungen

Wir haben nun einige der Fragen besprochen, die bei der Annotation von Partikelverben in Falko und RIDGES zu klären wären. Auch wenn es uns gelänge, damit eine teilmaschinelle Annotation nach unseren Vorstellungen zu entwickeln, zeigen diese Beispiele, wie essentiell es ist, die Entscheidungseigenschaften der automatischen Werkzeuge zu kennen und zu verstehen. Bei der Nachnutzung von vorhandenen Annotationen stellt sich somit wiederum die Frage, ob die Entscheidungen, die für deren Erstellung getroffen wurden, zu den eigenen Forschungsfragen passen. Das Beispiel der Partikelverbannotation wird in diesem Artikel aber nur stellvertretend für die Menge aller linguistischen Kategorisierungen verwendet, die über die Wortoberfläche hinausgehen. In diesem Abschnitt wollen wir erläutern, warum diese Probleme grundsätzlich und bei jeder Kategorisierung linguistischer Sprachdaten zu erwarten sind.

3.1 Anwendungskontext automatischer Tools und ihre historische Entwicklung

Automatisierte Werkzeuge sollen uns helfen, die linguistischen Elemente im Fokus unserer Forschungsfrage(n) zu identifizieren und zu klassifizieren. Hierbei unterscheiden wir semiautomatische und vollautomatische Annotationen. Während erstere einer computergenerierten Klassifikation einen manuellen Kontroll- und Korrekturschritt folgen lässt, vertraut die vollautomatische Annotation der Analyse des Computers und liefert unmittelbare – und unkontrollierte – Inhalte. Wir möchten hier darlegen, warum das in der korpusgestützten linguistischen Forschung niemals eine gute Idee ist. Wenn der manuelle Annotationsschritt, den wir als wichtigen Bestandteil des Forschungs- und Erkenntnisprozesses verstehen, übersprungen wird, so kann dies nur gerechtfertigt sein, wenn wir zwei Dinge ausschließen können: Erstens, dass wir entscheidende neue Erkenntnisse über das betrachtete Phänomen verpassen. Und zweitens, dass die automatische Modellierung in einer für uns undurchsichtigen oder schwer zu kontrollierenden Weise inadäquat, fehlerbehaftet oder unvollständig ist. Beides halten wir insgesamt für nicht zu garantieren bis ausgeschlossen, wenn uns die Modelle und Arbeitsweisen der Tools, die wir verwenden, nicht relativ detailliert vertraut sind.

Computergestützte Werkzeuge zur automatischen Annotation lassen sich grob in zwei Gruppen einteilen: regelbasierte und statistische Werkzeuge. Letztere lassen dabei noch weitere Unterteilungen zu, auf die wir später zurückkommen.

Regelbasierte Werkzeuge bestimmen die Herleitung einer gewünschten Ausgabe in expliziten, d. h. les- und nachvollziehbaren, Anwendungsregeln auf Eingabedaten. Diese können direkt im Quellcode des computerlinguistischen Werkzeugs festgeschrieben oder teilweise oder ganz in externen Konfigurationsmechanismen, z. B. graphischen Oberflächen, einstellbar sein. Sie können außerdem menschengemacht oder maschinell induziert sein, wie bei Systemen und Methoden der automatischen Grammatikinduktion, deren Modelle auch ein Ergebnis maschinellen Lernens sind.

Bei der manuellen Entwicklung von Regeln für eine angemessene Klassifizierung des Forschungsgegenstands reichen oft zunächst relativ einfache Regeln, um eine große Menge der Elemente korrekt zu annotieren.

„Korrekt“ bedeutet in diesem Fall, dass Elemente, die zu unseren Klassen gehören, als solche erkannt werden (true Positives), während Elemente, die nicht zu unseren Klassen gehören, richtigerweise nicht erkannt werden (true Negatives). Wir werden aber auch fälschlich erkannte Elemente finden (false Positives) – dann leidet die Präzision (Precision) unseres Werkzeugs. Außerdem wird es Elemente geben, die nicht wie gewünscht als unsere Zielklasse ausgezeichnet werden (false Negatives). In diesem Fall spricht man von einem niedrigen Recall. Sollte es gelingen, die Precision auf einem fixen Zielmaß zu halten, erhöht sich der Recall in immer kleineren Schritten.[37] Das lässt sich mit immer mehr, und oft auch komplexeren, Regeln bis zu einem gewissen Grad erreichen. Allerdings stößt dieses Aushandeln an eine natürliche Grenze, die weit unter dem liegt, was wir als Linguist:innen im Sinn haben. Nehmen wir an, ein System performt mit 90 % Korrektheit: Das wäre ein hoher Wert für viele maschinelle Analysemodelle, bei dem aber 100 von 1000 Vorkommen eines Phänomens nicht oder falsch erkannt würden. Obwohl sie nicht völlig ihre Daseinsberechtigung verloren haben – besonders in Forschungsansätzen, die an explizitem linguistischen Wissen interessiert sind (Bonfante et al. 2018; Guibon et al. 2020; Guillaume 2021) – entsprechen regelbasierte Ansätze darum nicht mehr dem heutigen Stand der computerlinguistischen Entwicklung (state of the art).

Stattdessen hat die Computerlinguistik sich größtenteils auf verschiedene statistische Ansätze verlegt. Hier lassen sich grob zwei Klassen unterscheiden:

|

1. |

Es gibt „klassische“ statistische Ansätze, zu deren Operation die Repräsentation der Eingabedaten gezielt manipuliert und optimiert wird, um im Modelltraining die besten Ergebnisse zu erzielen. Anders als bei regelbasierten Ansätzen erfolgt keine explizit kodierte und linguistisch interpretierbare Ableitung der Zielkategorien, sondern die modellierte Eingabe wird durch numerische Verfahren in eine vorgegebene Zielklasse umgewandelt. |

|

2a. |

Die zweite Gruppe statistischer Ansätze ist dem representation learning (RL, Bengio et al. 2013) zuzuordnen. Hier erfolgt keine explizite Modellierung des Inputs mehr. Dazu zählen die neuronalen Netze (komplexe mathematische Berechnungen, die sich in ihrer Ursprungsform als Vernetzung einer Abstraktion des biologischen Neurons als Recheneinheit beschreiben lassen) und das deep learning (für eine umfangreiche Einführung siehe Goodfellow et al. 2016), das Schichten parallel angeordneter Neuronen vielfach sequentiell verkettet und so die namensgebende Modelltiefe erreicht. |

|

2b. |

Als Untergruppe der neuronalen Netze haben im Besonderen die large language models (LLMs) in letzter Zeit viel Aufmerksamkeit gewonnen. Das aktuell prominenteste und bereits oben angesprochene Beispiel ist GPT-4 (OpenAI et al. 2023) mit seinem Interface ChatGPT. Die Nutzung dieser Modelle beschränkt sich nicht mehr darauf, festgelegte, an sich linguistische Aufgaben zu erfüllen. Hatten Tools zur Verarbeitung natürlicher Sprache (natural language processing, NLP) bisher dezidierte Aufgaben, z. B. eine bestimmte Klassifizierung oder Strukturierung, Tagging, Parsing, etc., kann GPT-4 scheinbar alles und hat zu allem eine Antwort. Wir können es sowohl darum bitten, uns einen Satz zu parsen, als auch die Wortarten seiner Bestandteile zu bestimmen und erhalten auch eine Antwort zu allen anderen Fragen. Im Standardfall ist diese Antwort nicht als Datenmenge strukturiert, sondern auch in natürlicher Sprache (wobei Ersteres auch möglich ist). Natürliche Sprache ist damit sowohl Anwendungsdomäne als auch zugleich selbst Werkzeug von LLMs – sie kombinieren scheinbar kategorielles Wissen mit der Fähigkeit, es anzuwenden und auszuformulieren. |

Diese Ansätze haben unter Nutzung massiver Rechenleistung bis dahin ungekannte Erfolge in der automatischen Annotation erzielt, obwohl oder gerade weil sie auf die explizite Modellierung der Inputdaten verzichten. Immer komplexere neuronale Architekturen lösen auf immer größer werdenden Datensätzen eine oder mehrere Aufgaben. Diese Erfolge täuschen teilweise darüber hinweg, dass sich die funktionalen Ziele der anwendungsorientierten Computerlinguistik von denen der korpuslinguistischen Forschung unterscheiden. Der Verzicht auf die Explikation der sprachlichen Strukturen und Inhalte hat einen Preis für die forschungslinguistische Anwendung, denn als Voraussetzung für die Anwendung im Forschungskontext hatten wir unter anderem die Bedingung formuliert, dass dieser Prozess vollständig, fehlerfrei und adäquat modelliert. Die Vollständigkeit ließe sich für den konkreten Anwendungsfall automatisiert noch testen. Die Fehlerfreiheit und Adäquatheit sind aber nicht automatisiert prüfbar, denn für den Abgleich bräuchten wir ein vollständiges Regelwerk bzw. eine vollständige Definition der kontextuellen Korrektheit, die wir ja gerade nicht haben – sonst könnten wir ein regelbasiertes Modell entwickeln, das die Aufgabe vollständig erfüllt. Die Performance von Modellen des Representation Learning kann lediglich auf Testdatensätzen evaluiert werden. Selbst wenn diese zufriedenstellend ist, erlaubt das jedoch keine Generalisierung über die Korrektheit und Adäquatheit der Modellierung im linguistischen Sinn oder über die Performance auf einem beliebigen Datensatz. Dazu kommt, dass linguistisch interessante Datensätze häufig gerade nicht einem extrahierbaren Durchschnitt aus einer großen beliebigen Datenmenge entsprechen bzw. dass dieser Durchschnitt nicht der Dynamik der einzelnen Teildatensätze entspricht.

Zu dieser Problematik gehört, dass wir nicht bestimmen können, was die Maschine lernt und was nicht – mit anderen Worten: wir wissen nicht, was sie eigentlich tut. Ausgehend von den hohen Performancescores von computerlinguistischen Anwendungen ist die Vermutung durchaus berechtigt, dass die Software bei der schieren Menge an gesehenen Daten etwas gelernt hat, das auch für uns Linguist:innen von Interesse sein kann. Dies ist jedoch nicht garantiert. Insbesondere kann bspw. Overfitting auftreten (z. B. Li et al. 2017), d. h., es ist möglich, dass die Maschine ein spezifisches, idiosynkratisches Muster für eine Datenmenge perfekt gelernt hat, das sich aber nicht kategoriell auf andere Datenmengen übertragen lässt. Da wir eben nicht wissen, was die Maschine gelernt hat, können wir auch keine gezielte Fehlerbehebung ansteuern.[38] Diese Feststellung disqualifiziert nicht den Einsatz automatischer Tools, ist aber ein wichtiger Hinweis zu deren angemessenem Einsatz im Forschungskontext, dem wir uns im Folgenden nähern wollen.

3.2 Das perfekte Tool und das menschliche Modell

Nehmen wir an, wir wollten unsere Annotationsaufgabe durch ein ideales Modell lösen. Es wäre ein neuronales Netz, das dem neusten Entwicklungsstand entspräche und das optimal die folgenden Aufgaben löst:

die Auszeichnung und Klassifizierung von linguistischen Items (z. B. was ist ein Partikelverb und was ist eine Verbpartikel (siehe Distanzstellung)?) und

die Annotation der Beziehungen zwischen diesen (Distanzstellung: Gehört zum beobachteten Verb eine Partikel innerhalb desselben Satzes?).

Dieses Netz erreichte in sich geschlossen, was man traditionell durch separate Anwendung zunächst eines Taggers und dann eines syntaktischen Parsers in Kombination versucht hätte. Wir möchten nun illustrieren, warum selbst unter so idealen Bedingungen ein Aussparen der linguistischen Analyse unserer Arbeit abträglich ist. Dafür erläutern wir die Arbeitsweise eines solchen statistischen Modells im Vergleich zur menschlichen Analyse.

Menschen entwickeln vor und während des Annotationsprozesses Annotationsrichtlinien, die eine Anleitung zur Operationalisierung der für die Forschungsfrage relevanten linguistischen Konzepte sind. Im Fall von Partikelverben verständigen wir uns auf die kleinsten zu annotierenden Einheiten, ihre technische Repräsentation sowie die Beziehungen, die zwischen ihnen bestehen können. Wir legen fest, was unsere kleinsten Einheiten als Partikelverb oder Verbpartikel qualifiziert und beginnen mit der Klassifizierung. Typischerweise schon bald stellen wir fest, dass unsere Richtlinien nicht ausreichen. In der Regel ist das ein Indikator, unser linguistisches Modell – also unser Verständnis des Phänomens – anzupassen und die Richtlinien zu überarbeiten. Ein wichtiger Schritt hierbei: Wenn unsere selbstgebauten Trainingsdaten den Anforderungen unseres linguistischen Modells nicht gerecht werden – sich also herausstellt, dass unsere erste Kategorisierung eigentlich gar nicht unseren linguistischen Vorstellungen entspricht – wenden wir es gar nicht erst an, sondern überarbeiten zunächst unser linguistisches Modell und/oder unsere Richtlinien, dann die Trainingsdaten.

Unser statistisches Modell arbeitet anders. Die zu annotierenden Daten müssen lediglich formale Standards erfüllen, d. h. sie müssen dem Modell in einem bestimmten Format und der richtigen Kodierung zugeführt werden (bei Large Language Models wie GPT-4 ist diese Schwelle besonders niedrig). Der Berechnungsweg für die Ausgabe ist strikt vorgegeben und konzeptuelle Abwägungen bzgl. der Anwendbarkeit der gelernten Kategorisierung auf die vorliegenden Daten finden nicht statt. Es wird eine Ausgabe erzeugt, deren Grundlage die in den Trainingsdaten gesehenen sprachlichen Muster sind, nicht ihre linguistische Abstraktion. Eine vordefinierte mathematische Formel wird berechnet und das Ergebnis in weiterverarbeitbarer und lesbarer Form ausgegeben. Es finden keine logischen Schließprozesse, sondern lediglich (wenn auch hochkomplexe) Berechnungen statt. Diese sind stets deterministisch, d. h., sie passen sich nicht dynamisch an veränderte linguistische Realitäten oder unvorhergesehene Kontextabhängigkeiten an.[39] Das bedeutet, dass es sich bei allen Berechnungen dieser Art um eine Übertragung einer Analyse eines Datensatzes auf neue Daten handelt, nicht um eine Neuanalyse, wie sie linguistische Forscher:innen vornehmen würden.

3.2.1 Das Tool und seine Trainingsdaten

NLP-Tools erzeugen durchaus hervorragende Ergebnisse auf ihren Trainingsdaten – sie sind schließlich darauf optimiert, genau die erwartete Ausgabe zu generieren. Daraus folgt aber nicht, dass sie uns helfen, Sprache besser zu verstehen, und auch nicht, dass sie vollautomatisch die Klassifizierung unserer Daten übernehmen können. Dies liegt auch an der konkreten Zusammensetzung der Trainingsdaten. NLP-Tools können in einer von zwei Varianten eingesetzt werden:

Das Tool verfügt bereits über ein extern vortrainiertes statistisches Modell, die Parameter zur Berechnung des Outputs sind in ihrer Anordnung fest und mit Werten vorbelegt.

Wir haben selbst bereits einen Teil unserer Daten annotiert und nutzen diesen Teildatensatz als Trainingsdaten für das statistische Modell unseres Tools, wir beeinflussen also die Belegung der Parameter mit Zahlenwerten.

Im linguistischen Forschungsalltag rechnen wir mit dem ersten Fall. Nehmen wir optimalerweise an, die Trainingsdaten sind händisch mit einem festgelegten Annotationsschema vorannotiert, das das mögliche Output des NLP-Tools festlegt. Selbst im Idealfall passt dieses Annotationsschema nicht zwingend zu unseren Daten oder unseren linguistischen Vorstellungen. Zudem wissen wir nicht, welcher Grad an theoretischen Überlegungen das Annotationsschema des Tools beeinflusst hat und ob diese mit dem von uns gewählten Verstehensansatz vereinbar sind. Darüber hinaus kann das Annotationsschema auch dafür gewählt sein, die Performance auf den Trainingsdaten zu optimieren oder umgekehrt, um eine generische Kompatibilität mit möglichst vielfältigen Daten zu organisieren (de Marneffe et al. 2021). Ein in dieser Weise zweckgebunden optimiertes Annotationsschema passt fast sicher nicht zu unserem Forschungskontext.

Nehmen wir aber kurz einmal an, dass sowohl das Annotationsschema selbst als auch die ihm zugrundeliegenden Annahmen mit unseren theoretischen Vorstellungen von Partikelverben vereinbar sind. Auch dann hat dies nicht zur Folge, dass der Annotationsprozess unserer Daten komplett automatisiert erfolgen kann. In einem solchen Fall rückt die natürliche Heterogenität sprachlicher Daten und damit eben die Unterschiedlichkeit der Trainingsdaten des statistischen Modells im Vergleich zu unseren Daten ins Zentrum. So ist es höchst unwahrscheinlich, dass unsere neuen Daten den Trainingsdaten so sehr gleichen, dass dieser Aspekt vernachlässigbar wäre. Das ist in diesem Fall keine Frage der grundsätzlichen Abstrahierbarkeit von Phänomenen, wie sie sich epistemologisch in allen Fachbereichen mit variierenden Gegenständen stellt: Menschliche Analysen vergleichen Gegenstände sinnentnehmend, um daraus Systematiken zu abstrahieren. So ist die Abstraktion bereits in der Wahl der Vergleichsaspekte enthalten. Computerlinguistische Tools hingegen vergleichen Strings und bilden dann Musterhaftigkeiten – nicht Sinnhaftigkeiten – auf andere Strings ab. Datensätze variieren jedoch inter- und intra-individuell, beispielsweise bzgl. Diachronie, Register, Autor:innenschaft, Sprechsituation und Beziehung zwischen den Sprecher:innen, Sprecher:inneneigenschaften, Sprachkontakt, Entstehungskontext und vieler weiterer Faktoren, die zusammen einen enormen Einfluss auf die Verteilung linguistischer Formen und Phänomene in unseren und den Trainingsdaten haben. Es ist im Einzelfall durchaus möglich, dass einige dieser Aspekte sich für den jeweiligen Zweck hinreichend ähnlich zwischen zwei Datensätzen verhalten. Diese Eigenschaft ist aber modellbezogen, d. h. sie verhält sich relativ zur Forschungsfrage, nicht zu den Strings. Die Maschine kann diese Einschätzung nicht treffen und versucht es auch nicht. Sie bildet schlicht ab, was sie auf anderen Strings musterhaft gelernt hat.

Ließe sich daraus nicht ableiten, dass ein NLP-Tool mit einem statistischen Modell, das möglichst vielseitige Daten bzgl. der genannten Faktoren in seinem Trainingsprozess gesehen hat, in der Lage sein sollte, adäquate Resultate zu erzeugen? Tatsächlich ist dies unwahrscheinlich, gerade weil die sprachliche Variation entlang der genannten Faktoren so stark ist. Denn die Trainingsdaten sind ja keine Menge gemittelter Sprache, sondern eine Menge kontextualisierter Sprache, die nur durch die Abstraktion von fast allen relevanten Variablen überhaupt gemittelt werden kann. Anders gesagt, ein Durchschnitt mit sehr hoher Varianz nützt niemandem, der ein Ergebnis für den Einzelfall möglichst präzise voraussagen will. Es ist also grundsätzlich nötig, eine Fehlerabschätzung auf einem Teil der eigenen Daten vorzunehmen, selbst wenn man sich für eine automatische Annotation entscheidet. Dafür bedarf es aber wiederum einer Lösungsschablone, also eines definierten Modells für den Einzelfall – und das lässt sich nur manuell als Ergebnis eines linguistischen Abwägungsprozesses definieren.

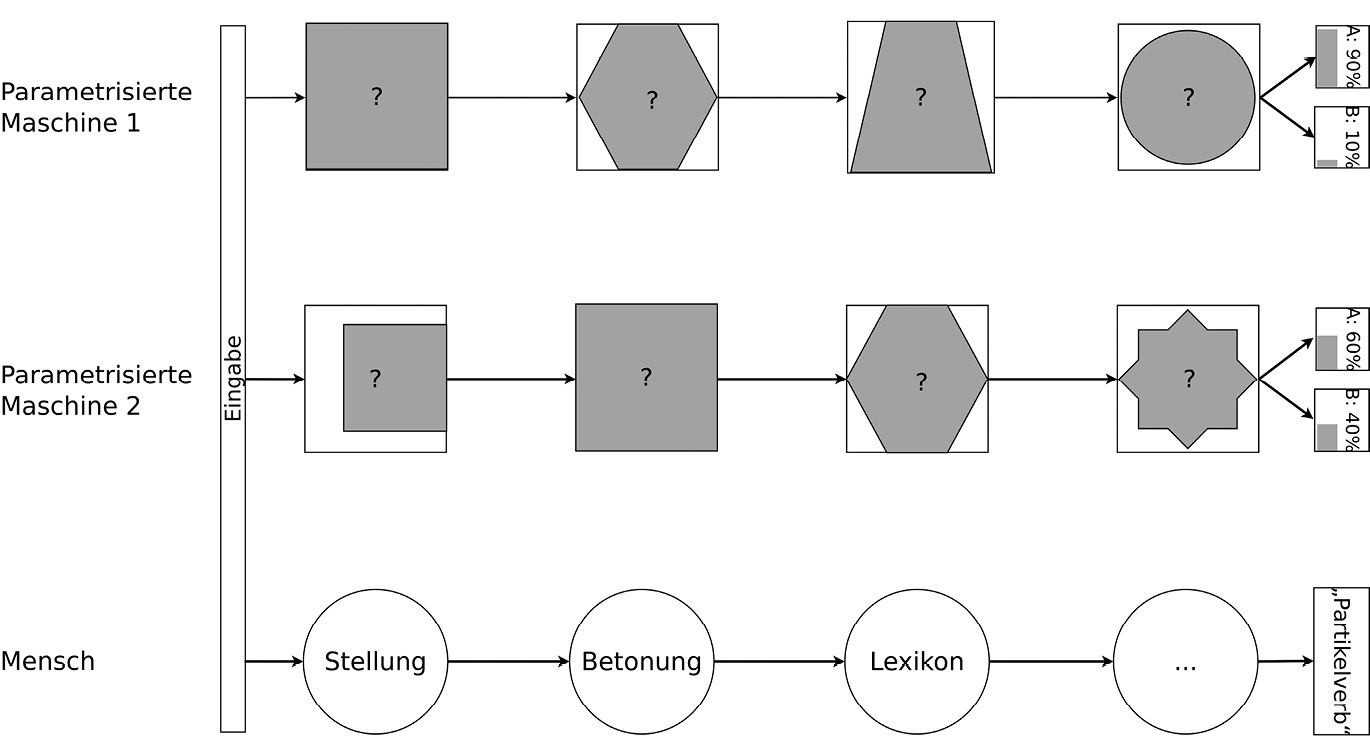

Die Klassifizierung beobachteter Wortformen läuft beim Menschen anders ab als bei der Maschine. Maschine 1 und 2 unterscheiden sich zunächst quantitativ und/oder qualitativ bzgl. ihrer Parameter (Werte, Anordnung, Anzahl, o. ä.) und kommen in ihrer Berechnung zwar zum gleichen Ergebnis, aber mit unterschiedlicher Sicherheit, was sich in den unterschiedlichen Wahrscheinlichkeitswerten der Klassen A und B ausdrückt. Eine Ursache für diesen Unterschied ist, dass Maschine 1 und 2 nicht auf den gleichen Daten trainiert wurden. Ob A „Partikelverb“ und B „kein Partikelverb“ bedeutet oder andersherum, liegt in der Konvention des Modells. Die Entscheidung, ob das Tag A oder B vergeben wird, hängt dann von den anderen kontextuellen Berechnungen ab. Beide Maschinen arbeiten erkennbar modular. Anders als beim Menschen ist die Funktion der einzelnen Module und ihre genaue Gestalt allerdings nicht immer von außen erkennbar. Der Mensch hingegen bezieht in seine Entscheidung die für sein Urteil relevanten Faktoren mit ein, wobei diese auf linguistischen Kategorisierungen basieren und in Richtlinien festgelegt sind. Im Beispiel sind es die Distanzstellung, die Partikelbetonung und ein möglicher Eintrag in ein Vergleichslexikon sowie weitere mögliche Faktoren, die den:die Annotator:in zur positiven Klassifizierung als Partikelverb bewegen. Auch wenn die Maschinen zum kontextuell gleichen Ergebnis kommen, ist das Modell nicht identisch und nicht einmal wirklich vergleichbar, da die Entscheidungsinhalte der Maschine oblik bleiben. Selbst wenn die Maschine in allen Fällen in den gewählten Daten zum selben Ergebnis käme, bedeutet das nicht, dass ihre Repräsentationen den menschlichen entsprechen (s. dazu auch der kluge Hans, ein Pferd, das scheinbar zählen konnte – jedenfalls hob es auf Kommando die richtige Anzahl Male seinen Huf. In Wirklichkeit reagierte Hans auf kleine Signale in der Körpersprache seines menschlichen Auftrittspartners (Pfungst 1907)). In unserem Beispiel wird die Kategorisierung der beiden maschinellen Modelle aber auch nicht in allen Fällen zum selben Ergebnis kommen, da die Kategorienverteilungen (Wahrscheinlichkeit der Kategorie A/B) sich unterscheiden. Welche gemessen am menschlichen Urteil besser performt, lässt sich allgemein nicht beantworten. Wahrscheinlich scheitern beide an wichtigen Punkten.

Die Abhängigkeit des Tools von seinen Trainingsdaten und eine Festlegung des statistischen Modells auf eine hohe Wahrscheinlichkeit bestimmter sprachlicher Strukturen schließt heute nicht mehr aus, dass auch Vorhersagen für ungesehene Formen und Strukturen erzeugt werden können. Wir haben das bereits am vom Treetagger angenommenen Verb dingen weiter oben gesehen. Diese müssen auch nicht zwingend falsch oder gar zufällig sein. Die Stärke moderner neuronaler Modelle als Modelle des Representation Learning liegt auch darin, Muster identifizieren zu können, die sich der regelbasierten Beschreibung durch Ableitungen aus einem gegebenen Lexikon entziehen. Darin liegt aber gleichzeitig die Schwäche solcher Modelle. Sie schließen eben nicht linguistisch, wie es den Anschein haben mag. Stattdessen generalisieren sie durch Anwendung der gelernten mathematischen Funktion, was mal mehr und mal weniger gut funktioniert, d. h., sie übertragen gleichbleibende Muster – die wir nicht kennen und nicht verstehen – auf unterschiedliche Daten. Mit Blick auf linguistische Fragestellungen ist das oft zu ungenau (siehe auch Abbildung 5), weil unsere Anwendungsdaten nicht den Strukturen entsprechen, die das Modell kennt. Wichtiger ist aber, dass die Maschine nicht zweifelt. Sie hört nicht auf zu analysieren, weil sie etwas nicht kennt oder es nicht zu ihrem Training passt. Sie wird vielmehr das nächstwahrscheinliche Muster als Analyseergebnis anbieten. Dabei ist Nähe hier ebenfalls nicht linguistisch, sondern mathematisch anhand der eigenen – oft unbekannten – Parameter der Maschine definiert. Es kann zu ganz guten Annäherungen kommen oder auch zu völlig falschen Ergebnissen. Leider wissen wir nie, wann welcher Fall eintritt und es ist für uns auch nicht zu erkennen, bei welchen Fällen die Maschine überhaupt zweifeln hätte sollen. Die maschinelle Analyse ist also auch in dieser Hinsicht keine Automatisierung des menschlichen Analyseprozesses, denn sie analysiert nicht wie ein Mensch, d. h. in einem epistemologischen Sinn, durch die kontextuell spezifizierte Verbindung verschiedener Konzepte und Anforderungen. Wo die menschliche Analyse Konzepte und Inhalte sinngemäß abstrahiert, verschiebt die Maschine Muster, die sie als optimal für die Beschreibung der Zeichenfolge in einer vorherigen Datenmenge betrachtet hat, auf eine neue Datenmenge.

Syntaktische Annotation eines Partikelverbs nach dem SUD-Schema anhand eines Beispiels aus dem Falko-Korpus (cbs001_2007_10_L2v2.4)

Syntaktische Annotation eines Partikelverbs nach Foth (2006) anhand eines Beispiels aus dem Falko-Korpus (cbs001_2007_10_L2v2.4)

3.2.2 Abhängigkeit von Annotationsentscheidungen

Wir haben gezeigt, warum auch ein ideales Annotationstool unser Problem nicht wirklich lösen kann. Ausgegangen waren wir aber von einer Verkettung von existierenden Tools, die die einzelnen Module dieses Entscheidungsprozesses automatisieren. Da diese im Allgemeinen vorliegen (Tagger, Parser, etc.), wäre es einladend, sie einzeln zu optimieren bzw. optimiert vorzufinden (der beste Parser + der beste Tagger etc.) und dann zusammenzuschalten. Jedoch stellen sich auch dann Fragen der Übertragbarkeit – auch wenn wir Zugang zu einem perfekten Wortartentagger und einem perfekten syntaktischen Parser hätten, ergäbe sich daraus für den allgemeinen Fall keine optimale Lösung.

Zerlegen wir zunächst unsere linguistische Fragestellung in die für beide Tools spezifischen Teilprobleme: die Kategorisierung einzelner Wörter (Was ist eine Partikel? und Was ist ein Partikelverb?) sowie die Beziehung zwischen Wörtern (Distanzstellung von Verbstamm und Verbpartikel). Die Abbildungsproblematik verteilt sich somit auf (mindestens) zwei Teilmodellierungsfragen. Aber auch dieser Eindruck greift zu kurz: Zwischen den Modellierungsschritten besteht zudem eine Abhängigkeitsbeziehung. Betrachten wir die Analyse syntaktischer Beziehungen in unseren Daten und ziehen beispielhaft zwei existierende Annotationsschemata der Dependenzsyntax heran, Surface Syntactic Universal Dependencies (SUD; Kahane et al. 2021) und die Dependenzgrammatik nach Foth (2006). Beide Schemata lassen sich zumindest für das Gegenwartsdeutsche anwenden. Ebenfalls ist beiden Schemata gemein, dass sie die syntaktische Beziehung zwischen Verbpartikel und flektiertem Verbstamm bei Distanzstellung explizit kodieren. SUD zeichnet eine Kante vom Verbstamm zur Partikel als compound@prt aus, eine gleich gerichtete Kante nach Foth (2006) trägt das Label AVZ (siehe Abbildungen 6 und 7).

Beide Klassifizierungen beschränken sich auf Partikelverben und haben keine weitere Funktion. In ihrer Bestimmung unterscheiden sie sich jedoch nicht unwesentlich: Während Foth (2006) auf der Wortartenklassifizierung nach STTS (Schiller et al. 1999) aufbaut und entsprechend die syntaktische Beziehung zwischen Verbstamm und Partikel direkt aus dieser ableiten kann (in STTS sind Verbpartikeln eindeutig als PTKVZ ausgezeichnet), ist die Zuweisung nach SUD etwas komplexer. Auch SUD berücksichtigt die Wortartenklassifikation, allerdings ist dieses Schema auf sprachuniverselle Anwendbarkeit ausgelegt. Verbpartikeln sind in diesem entweder Adverbien (ADV) oder Adpositionen (ADP), je nach lexikalischem Ursprung. Es findet also bei der Auszeichnung der Beziehung zwischen Verbpartikel und Verbstamm in Distanzstellung implizit ein zusätzlicher Modellierungsschritt statt, die funktionale Auszeichnung lexikalischer „Grundbausteine“ mit ihrer syntaktischen Funktion als Verbpartikel. In diesem Ansatz finden sich bereits viele weitere konzeptuelle Annahmen bzgl. Morphologie und Syntax, die sich vom Ansatz nach Foth (2006) und STTS unterscheiden. Uns geht es hierbei aber vor allem um die Unterschiede im Aufsetzen eines syntaktischen Annotationsschemas auf eine Wortartenklassifikation, die eben nicht flexibel gestaltbar ist. Maschinelle Annotationsschemata sind also selbst auch Modelle, die zweckgebundene Annahmen machen. Es kann dadurch zu konzeptuellen Brüchen kommen, die eine Kombination verschiedener Ebenen und Modelle ohne weitere Anpassung verunmöglichen. Und das, obwohl wir nur eine Teilmenge unserer Problematik betrachtet haben: Partikelverben in modernen Sprachstufen des Deutschen in Distanzstellung. Diese Probleme stellen sich sowohl menschlichen Annotator:innen als auch automatischen Tools, wobei letztere jedoch nicht von einer Klassifizierung „zurückschrecken“, die wenig sinnvoll bzw. in sich inkonsistent ist.[40]

3.2.3 Semiautomatische Annotation für maximale Synergie

Nun wäre es ein Fehler, aus dem Geschilderten zu schließen, eine Anwendung computerlinguistischer Tools müsse um jeden Preis vermieden werden. Vielmehr dient unsere Fokussierung auf ihre Schwächen der Warnung vor einem Vertrauen in die Ergebnisse vollständig automatischer Annotation und insbesondere ihrer Verkettung. Im Kontext von korpuslinguistischer Arbeit können Tools die Annotationsarbeit dennoch maßgeblich verkürzen, besonders, wenn wir ein bereits bestehendes Annotationsschema zweifelsfrei wiederverwenden können und hierfür bereits ein Tool vorhanden ist, solange dessen Anwendung und die folgende manuelle Nachkorrektur insgesamt weniger Zeit und Ressourcen verbrauchen als die rein manuelle Annotation. Aber auch, wenn wir unser Schema erst entwickeln, kann es sich lohnen, ein Modell auf einer Untermenge unserer Daten zu trainieren und auf die verbleibenden anzuwenden, sofern wir davon ausgehen können, dass sich beide Datenmengen strukturell sehr ähnlich verhalten. Auch hierbei gilt, dass deren Nachkorrektur grundsätzlich erforderlich ist und nicht zu ressourcenaufwändig verlaufen darf. Statt der Anwendung eines statistischen Modells ist zudem die regelbasierte automatische Vorannotation dem manuellen Annotations- und damit Forschungsprozess näher, wobei die Regeln von den Annotator:innen selbst definiert werden. Gleichzeitig wird im Prozess erworbenes Wissen dokumentiert und kodifiziert. Durch Anpassung unserer Regeln nach deren Anwendung auf die Daten und deren Korrektur zur Verbesserung der Ausgabe erhalten wir schließlich eine explizite Form unseres linguistischen Modells, d. h. unserer linguistischen Vorstellungen und Annahmen, die wir so auch explizit und punktgenau hinterfragen können.

4 Die Abbildung als Grundproblem der Korpuslinguistik

Wir haben bereits herausgearbeitet, dass die Annotation ein linguistischer Kategorisierungsprozess ist, der von vielen theoretischen Annahmen abhängt und zahlreichen Wechselwirkungen unterliegt. In unserem Beispiel der Partikelverben haben wir gesehen, dass schon die Ebenen Tokenisierung, Wortartenbestimmung und Lemmatisierung nicht trivial sind und welche Probleme dabei jeweils der Maschine und auch den menschlichen Annotator:innen begegnen. Nachdem wir diesen Erkenntnisprozess durchlaufen haben, können wir gemäß unseren Vorannahmen und Zielsetzungen eine Analyse in unser Korpus integrieren und dieses zur Nachnutzung anbieten.

Es bleibt nun festzustellen, dass neue Nutzer:innen unseres Korpus die vorher benannten Abbildungsprobleme gleichfalls erfahren werden, wenn sie unsere Annotationen nachnutzen wollen. Das gilt auch, wenn unsere Annotationen sorgfältig dokumentiert und in die Korpusarchitektur integriert sind: Die Verknüpfung verschiedener Text- und Bedeutungsebenen ist immer ein Problem der Abbildung und der Verknüpfung verschiedener Kategorien auf- bzw. miteinander, die Modelle von Phänomenen mit zuweilen sehr unterschiedlichen Eigenschaften repräsentieren. Das gilt unabhängig davon, an welcher Stelle wir in den Text einsteigen, wie das Schaubild in Abb. 8 verdeutlicht. Ob wir ein Korpus mit bereits vorhandenen Annotationen unseres Phänomens wählen – hier können wir nicht davon ausgehen, dass diese Annotationen unseren Vorstellungen und Annahmen entsprechen – oder ob wir die Annotationen auf anderen, bereits vorhandenen Annotationsebenen aufbauen wollen, wie in unserer Beispielannotation der Partikelverben. In dem Fall können wir nicht davon ausgehen, dass die darunterliegenden, vorhandenen Annotationen unseren Vorstellungen und Annahmen entsprechen. Nur wenn wir selbst manuell oder unter Berücksichtigung der Detaileigenschaften der vorhandenen Annotationen teilmaschinell annotieren, können wir davon ausgehen, dass unsere Annahmen, sofern wir sie explizit machen, erfüllt sind. Wenn Annotationen vorhanden sind, müssen wir sie genau prüfen, und wenn keine vorhanden sind, müssen wir sie prüfend erstellen. Haben wir sie erstellt, ergibt sich dieselbe Notwendigkeit für alle Nachnutzer:innen, deren Forschungszwecke von anderen Annotationsbedarfen – auch derselben Phänomene – geprägt sein können.

Dieser Reflexionsprozess ist von besonders hoher Bedeutung bei der Betrachtung von sprachdynamischen und emergenten Phänomenen. Hier entstehen nicht nur durch maschinelle, sondern auch durch menschliche Verschiebungen von Analysemustern blinde Flecken im Forschungsprozess: Will man beispielsweise wissen, wie sich die Produktivität von Partikelverben in Sprachkontaktsituationen von der in monolingualen Sprachsituationen unterscheidet, reicht es nicht, einen Partikelverbparser anzuwenden, der auf monolingualen Sprechsituationen trainiert ist. Selbst wenn er dort optimal arbeitet, wird er höchstwahrscheinlich genau die Fälle nicht abdecken, die sich von der monolingualen Situation unterscheiden. Die annotierten Daten wären also gerade im entscheidenden Bereich systematisch verzerrt. Dasselbe passiert jedoch, wenn man ein Annotationsschema für ein Phänomen auf einer Teilgruppe entwickelt, diese Gruppe damit de facto zum Normalfall erklärt, und die andere Gruppe nur durch das erste Schema betrachtet.

Darum ist es für dynamische Prozesse von besonderer Wichtigkeit, die Unabhängigkeit des eigenen theoretischen Modells zu prüfen und bestehende Parametrisierungen (z. B. des eigenen Denkens, aber auch der Maschine) als explizites Abbildungsproblem zu verstehen. Relevant wird dieses Problem nicht nur in Sprachsituationen, die streng genommen in sich besonders dynamisch sind, sondern immer dann, wenn bestehende Ontologien auf Systeme und Ökologien angewandt werden, für die sie nicht entwickelt wurden, also z. B. auch von gesprochener auf Gebärdensprache (Johnston 2014, S. 164).

Sind alle diese Probleme bedacht und integriert, müssen auch noch die Schnittstellen zum Analysemodell unserer Wahl, z. B. frequentistischer Statistik oder einer graphbasierten Analyse, richtig definiert sein, damit wir exakte Vorstellungen von unserer Grundgesamtheit, unseren Zähleinheiten und Normalisierungsgrößen haben. Wie alle Kategorisierungen sind auch diese Passungen nicht naturgegeben, sondern unterliegen komplexen Entscheidungs- und Erkenntnisprozessen (s. a. Larsson und Biber 2024).

Natürlich ist im Sinn der Datennachhaltigkeit die Nachnutzung von Korpora zu empfehlen. Bei historischen Korpora und in wenig belegten Sprachen ist sie sogar unumgänglich. Dennoch ist ein Bewusstsein für die Vielschichtigkeit der Abbildungsprobleme von zentraler Bedeutung.

Die Annotation von Korpusdaten stellt eine (möglichst) vollständige Einzelfallanalyse linguistischer Phänomene innerhalb der gewählten Evidenzmenge dar. Damit stößt sie zwingend an die Grenzen der linguistischen Theorie, weil linguistische Theorien in der Regel nomothetisch, also generalisierend sind. Sie versuchen im Normalfall nicht, die einzelne Äußerung möglichst komplex und detailreich zu analysieren, sondern stellen Regeln für den grundsätzlichen Fall auf (auch wenn der Detailgrad der Abgrenzung hier variieren kann).[41] Die Korpuslinguistik, soweit sie komplexe linguistische Phänomene detailliert annotiert, ist insofern speziell, als dass sie den Einzelfall so weit verfolgt, dass sie an die Grenzen der Nomothese der linguistischen Modelle und beinahe in Bereiche der Idiographie gerät, diese gefundenen idiosynkratischen Eigenschaften dann aber in die Kategorienbildung zurückleitet. Arppe et al. (2010, S. 5) unterscheiden dafür noch zwischen den Begriffen der korpuslinguistischen Analyse (einer qualitativen Analyse von Korpusdaten) und der komputationellen Korpusanalyse (einer statistischen Auswertung des gemeinsamen Vorkommens linguistischer Formen). Über ein Jahrzehnt später ist die Methodologie der Korpuslinguistik aber so weit fortgeschritten, dass sie gleichsam ein quantitativ-komputationelles und ein qualitativ-hermeneutisches Fach darstellt.

Daraus ergibt sich ein dialektischer Auseinandersetzungsprozess zwischen dem Allgemeinen und dem Besonderen, der immer im Spannungsfeld der vorhandenen Kategorien und Modelle steht. Je komplexer das Phänomen, desto mehr interagierende Modelle, und desto mehr mögliche Interaktionen und Interpretationen. Auch deshalb kann es keine generellen und allumfassend „richtigen“ Annotationen geben. Im besten Fall erhält man eine gut dokumentierte, linguistisch tief durchdachte und in sich stimmige Menge von plausiblen Zuweisungen. Das kann von enormem Wert für die Forschung sein, es ist aber keine finale Lösung eines linguistischen Problems.

Wenn eine ein-eindeutige „richtige“ Annotation nicht möglich ist, folgt, dass sie nicht notwendig ist und somit auch kein Ziel der korpuslinguistischen Arbeit sein sollte. Annotation ist ein Forschungsprozess mit dem Ziel, ähnliche Dinge im Korpus auffindbar und wiedererkennbar zu machen und durch diesen Prozess ein tiefes Verständnis für das betrachtete Phänomen und seine Repräsentation in den eigenen Daten zu entwickeln. Was ähnlich ist, wird durch das eigene linguistische Modell und den Zweck der Kategorisierung, nämlich die Forschungsfrage, bestimmt. Eine Parallelführung mehrerer Analysen ist plausibel und durch eine geeignete Korpusarchitektur auch möglich. Für die eigene Forschungsfrage steht nicht die allgemeine Korrektheit der Beschreibung im Vordergrund, sondern die Beherrschbarkeit der Daten im Rahmen der eigenen Arbeit. Entsprechend sollte das Ziel von Annotationsarbeit in Korpusprojekten nicht in der finalen Analyse einer Korpusebene bestehen, sondern in der Bearbeitung von Daten im Sinne einer gewählten Forschungsfrage.

Korpusanalysen erfordern grundsätzlich eine Klärung des gewünschten Analysemodells. Auch wenn ein Korpus Annotationen zu einem Phänomen unserer Wahl enthält, ist sorgfältig zu prüfen, ob diese den Anforderungen der Forschungsfrage entsprechen. Dasselbe gilt für automatisch erstellte Annotationsebenen. Auch diesen liegen Annahmen zu Grunde, die zunächst im Sinn der eigenen Forschungszwecke zu prüfen sind. Nur die manuelle Annotation zumindest einer Teilmenge der Daten gibt Aufschluss darüber, welche spezifischen Eigenschaften die gewählten Daten in Beziehung zum gewählten Analysemodell besitzen. Darin liegt die Erkenntnis über die Daten, aber auch über die Grenzen der zugrundeliegenden linguistischen Theorien. Aufbauend auf diesen Erkenntnissen lässt sich ggf. ein teilmaschineller Annotationsprozess nachbilden. Die dann ins Korpus aufgenommenen Annotationen führen aber für alle Nachnutzer:innen zurück zu Fall 1, denn ihre Forschungszwecke können von anderen Annotationsbedarfen auch derselben Phänomene geprägt sein.

Wenn es keine allgemeine Korrektheit gibt, gibt es natürlich auch keine maschinelle Lösung zu ihrer Herbeiführung. Somit ergibt sich sowohl aus den Eigenschaften der zur Verfügung stehenden maschinellen Methoden als auch aus der linguistischen Betrachtungsweise keine Vollständigkeit der Beschreibung. Die linguistische Datenmodellierung ist darum keine Vorverarbeitung und die maschinelle Verarbeitung der Daten und ihre technische Modellierung immer erst der zweite Schritt. Zunächst muss sehr gut verstanden und beschrieben sein, was die Abbildung aus linguistischer Sicht überhaupt leisten soll. Das bedeutet auch, dass der linguistische Erkenntnisgewinn, nämlich Einsichten über die linguistischen Kategorien, ihre Interaktionen, Dynamiken, Verteilungen und Grenzen, gerade in der Anwendung der linguistischen Modelle auf Daten liegt, also in der Annotation und der inhaltlichen Verknüpfung verschiedener Annotationsebenen.

5 Best Practices: Modellstruktur und Beherrschbarkeit

Unsere Ausführungen betreffen bislang den reflektierten Umgang mit maschinellen Analysetools und der Nachnutzung von vorhandenen Kategorisierungen. Nun bleibt dennoch als reale Hürde die Tatsache, dass die manuelle Annotation nicht nur zeit- und ressourcenaufwändig ist, sondern oftmals auch konzeptuelle Schwierigkeiten aufwirft. Wir wollen darum in diesem letzten Abschnitt einige Strategien vorschlagen, die der besseren Datenbeherrschung dienen, indem sie einen reflektierten und strukturierten Umgang mit dem manuellen Annotationsprozess unterstützen.

5.1 Überlegter Umgang mit erwartbarer Ambiguität

Neben den bisher beschriebenen Kategorisierungsprobleme, die durch ein (ggf. noch) unklares Verständnis des zu bearbeitenden Phänomens entstehen und die nur durch eine tiefere Auseinandersetzung mit dem Phänomen wirklich ausgeräumt werden können, sind unterschiedliche Arten von Ambiguität zu erwarten. Sie erfordern jeweils eigene Strategien. Einige sind grundsätzlich nicht auflösbar: Bei einer Lacuna (einer Textlücke) in einem historischen Dokument kann es sein, dass der Kontext eines Wortes nicht mehr herstellbar ist und es nie wieder sein wird, ähnlich ist es bei Unleserlichkeiten in handschriftlichen Daten. Diese Ambiguitäten generieren Lücken im Text, für die vor allem eine technische Entscheidung zu treffen ist (sollen z. B. Token leer bleiben dürfen/will man eine Abbildung der Lücke? Darf die Lücke ggf. als Nomen oder Verb interpretiert werden, wenn dadurch syntaktische Abhängigkeiten ermöglicht werden?). Strukturelle Ambiguitäten hingegen werfen konzeptuelle Fragen auf. Hierbei ist zu unterscheiden zwischen solchen, die grundsätzlich innerhalb eines Modells aufgelöst werden können – die also kontextuell eindeutige Kategorisierungen erlauben – und solchen, die auch im Kontext ambig bleiben. Zu ersteren zählt z. B. die Homomorphie des Voll- und Auxiliarverbs haben, zu den zweiten etwa die Interpretationsambiguität der Einbindung von Präpositionalphrasen an einzelne Nomen oder als Satzattribut am Vollverb (co-lexification und co-grammification nach Haspelmath 2023).

In der maschinellen Analyse ist dem Umgang mit struktureller Mehrdeutigkeit oft durch eine Entscheidung in eine festgelegte Richtung ausgewichen worden. Bei der Anbindung von Präpositionalphrasen im Satz erfolgt in manchen regelbasierten Parsern beispielsweise immer eine Anbindung an den jeweiligen Satzknoten, und im Stuttgart-Tübingen-Wortartentagset (STTS) wird für haben und sein immer das Auxiliar-Tag VA vergeben, selbst wenn sie im konkreten Fall Vollverben sind (s. bspw. Westpfahl et al. 2017). In solchen Fällen ist einerseits klar, was zu erwarten ist, andererseits können bestimmte Phänomene nicht ohne Weiteres untersucht werden oder müssen aufwändig manuell auseinandersortiert werden. Eine Variante davon sind neuere Lösungen, die den Kontext einbeziehen, also für homographe Formen aus einer Auswahl von möglichen Labels das Wahrscheinlichste wählen. Auch hier wird aber für oberflächenähnliche Kontexte (d. h. nicht zwingend analytisch ähnliche Kontexte) immer dasselbe, eben das wahrscheinlichste, Label verwendet.

Die linguistische Kategorisierung geht hier natürlich nicht statistisch, sondern kategoriell vor. Das Problem ist, dass das, was als Kontext und korrekte Kategorisierung gilt, auch für den Menschen für verschiedene Ausdrücke unterschiedlich sein kann. Bei der Frage, ob ein beliebiges an in einem Satz eine Verbpartikel oder eine Präposition ist, braucht man syntaktischen Kontext und ein syntaktisches Modell. Wenn man sich aber fragt, ob ein an in einem Wandelkontext bereits eine Verbpartikel ist oder noch eine Präposition, braucht man ein syntaktisches Modell für eine bestimmte Sprachstufe und eine Vorstellung davon, welche Variation in der betrachteten Sprachstufe vorherrscht. Für solche prinzipiellen Fragen bedarf es einer Annotationsrichtlinie, die kontextuell angemessene Entscheidungen festlegt. Manche Ambiguitäten sind dann zwar prinzipiell auflösbar, werfen aber technische Herausforderungen auf, z. B. weil sie doppelte Abhängigkeiten ausdrücken. Im Partikelverbkontext betrifft das häufig die Verwendung von Ellipsen und Auslassungen: Er schiebt die Tasse rüber und die Tür zu (rüber und zu hängen beide von schieben ab, das lässt sich dependenzgrammatisch leicht umsetzen, erfordert aber eine Lösung für die Lemmatisierung von [rüber|zu]schieben) oder Er drückt und schiebt die Tür zu (zu hängt von zwei Köpfen ab, das lässt sich dependenzgrammatisch nicht umsetzen). In diesem Fall muss eine Entscheidung getroffen oder das Modell so angepasst werden, dass es doppelte Kopfzuweisungen erlaubt und auch technisch ermöglicht. Interessanter noch wird es, wenn Kategorien unscharf definiert sind, wie wir es in vielen Beispielen oben (z. B. Klavier spielen) gesehen haben. Hier kann es auch auf Grundlage derselben grammatischen Modelle, sofern sie diesen Fall nicht explizit behandeln, zu unterschiedlichen Einschätzungen – also Unsicherheiten – kommen.

Hier ist wichtig, zu verstehen, dass Menschen unter Unsicherheit nicht modellrational denken, sondern heuristisch (s. a. Chen et al. 2014, Griffin et al. 2001 und Tversky und Kahneman 1974), und dass dabei verschiedene kognitive Verzerrungen (Biases) und Kategorienverkettungen auftreten, die nicht unbedingt dem Forschungsziel entsprechen. Besonders häufig entstehen dann entweder „Restekategorien“, in denen sich alles sammelt, was nicht in die anderen Kategorien passt, oder Kategorien auf Basis von Familienähnlichkeiten. Bei der Familienähnlichkeit handelt es sich um ein Kategorisierungprinzip, das von einer Verkettung von Teileigenschaften der Elemente einer Menge ausgeht (s. a. Wittgenstein 1967 und Wennerberg 2011; ähnliche Konzepte finden sich in kognitiv-semantischen Modellen wie Prototypentheorien oder Exemplarmodellen, siehe bspw. Divjak und Arppe 2013). So sehen die Mitglieder einer Familie einander häufig mengenweise ähnlich: Vielleicht haben zwei Mitglieder dieselbe Nasenform, eins davon teilt sich mit einem dritten außerdem die Haarfarbe, während das andere eine andere Haarfarbe hat, aber eine ähnliche Statur wie ein viertes etc. Insgesamt ergibt sich somit ein Pool von Eigenschaften, deren Verkettung als Ähnlichkeitsprinzip der gesamten Menge wahrgenommen wird, obwohl nur jeweils wenige Elemente sie tatsächlich teilen. Im Korpus hieße das, Element 2 in Kategorie A zu sortieren, weil es so ähnlich ist wie Element 1, das nach seinen Eigenschaften schon in Kategorie A ist: einpacken ist wie wegpacken ist wie wegräumen ist wie verräumen – Moment, das letzte ist kein Partikelverb.[42]